Ahora que ya os he explicado qué es crawl budget y por qué es importante para el SEO, intentaré mostraros cómo podemos optimizarlo.

¿Cómo aumentar la frecuencia de rastreo?

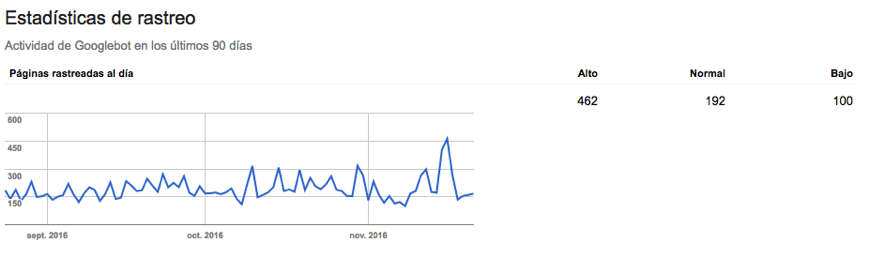

Antes de entrar en materia existe un punto que está muy relacionado con este tema y que es muy importante tener en cuenta. A parte de intentar aprovechar lo más eficientemente posible las visitas de los crawlers, otro frente en el que debéis trabajar es en la mejora de la frecuencia de rastreo de vuestro sitio web, es decir, cada cuanto visitan los crawlers vuestra web y cuántas páginas rastrean en cada visita.

Existen muchas vías para mejorar la frecuencia de rastreo de un site. A continuación os comento las que mejores resultados me han dado:

- Es necesario ir creando páginas nuevas e ir adaptando el contenido de las que ya tenemos publicadas para que Google vea que el contenido de vuestro site es fresco y original.

- Os recomendamos aumentar el número de enlaces externos (incluidos redes sociales) que apuntan hacia vuestro site de forma recurrente.

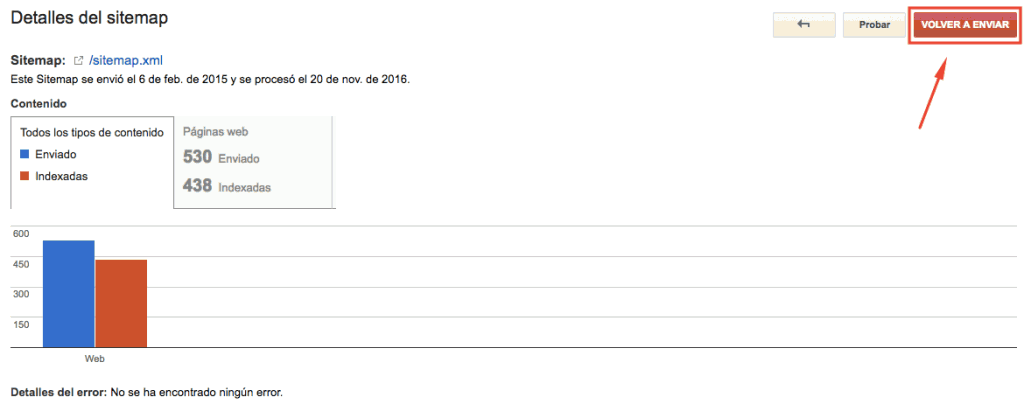

- Actualizar a menudo el o los sitemaps de vuestro site y hacerle un ping a Google para que lo venga a rastrear.

¿Cómo optimizar al máximo nuestro crawl budget?

A grandes rasgos, se trata de optimizar la arquitectura interna (enlazado interno) del site y “dirigir” (vía robots.txt) al crawler sólo a aquellas páginas operativas (sin errores) que nos interese indexar y potenciar para intentar aprovechar al máximo todos los recursos que Google nos asigna.

Las acciones que os recomiendo encarecidamente que llevéis a cabo para conseguir este objetivo son las siguientes:

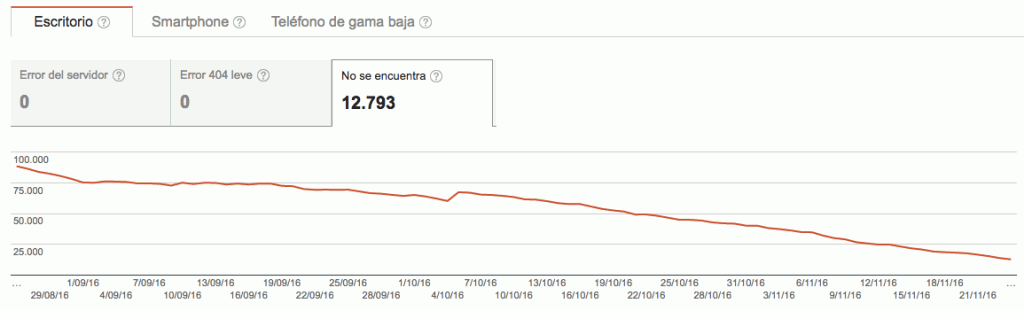

- Encontrar y ponerle solución a todas aquellas páginas del site que dan errores 4xx y 5xx para evitar que el crawler malgaste recursos en visitar páginas inexistentes.

- Con el mismo objetivo que el punto anterior, deberíais optimizar el enlazado interno de vuestro sitio web para que apunten a URLs finales, evitando apuntar a páginas con redirecciones

- Detectar y ponerles solución a todas aquellas páginas que tengan contenido duplicado.

- Utilizar el robots.txt para evitar que el crawler malgaste tiempo en aquellas páginas que no nos interese.

Existen infinidad de herramientas para trabajar en estos puntos, desde Search Console hasta Screaming Frog, pero os recomiendo encarecidamente profundicéis en el tema del análisis de logs del servidor ya que seguramente sean los datos más fiables que podréis conseguir.