Cuando hablamos de SEO nos vienen a la cabeza aspectos como las palabras clave, el contenido, los elementos On Page (metas, headings, imágenes, etc..) entre factores SEO. Es decir, en lo primero que solemos pensar es en elementos que van orientados a la optimización de queries, dejando de lado aspectos muy importantes como, por ejemplo, la optimización del Crawl Budget que los buscadores nos asignan.

En el post de hoy os explicaremos las bases para entender todo lo relacionado con este tema y también explicaremos a fondo cómo optimizarlo. Además, hemos incluido uno de los vídeos de nuestro canal de Youtube para que puedas visualizarlo. ¿Empezamos?

¿Qué es un crawler?

Aunque muchos de vosotros ya sepáis como funciona Google, es interesante hacer un repaso antes de entrar en materia.

¿Alguna vez os habéis preguntado cómo encuentra Google un sitio web? Los principales buscadores se sirven de rastreadores web, en adelante crawlers, para conseguir este objetivo. Un crawler no es más que una pequeña pieza de software que va navegando por Internet siguiendo todos los enlaces que se encuentra con el objetivo de recopilar toda la información de las páginas que ha visitado y guardarla en sus servidores. A partir de ahí, estos ordenan toda esta información en función de unos parámetros y la guardan en su índice para después mostrársela a los usuarios. Aunque pueda parecer sencillo, este proceso es más complejo de lo que parece.

Cómo habéis notado, al hablar de buscadores, siempre hago referencia a Google y, en parte, esto normal ya que en España es el buscador más utilizado con diferencia. Por este motivo vamos a centrar un poco más la explicación en el crawler de Google, que no es otro que Googlebot.

En el fondo, Googlebot no se compone solo de un rastreador ya que Google utiliza varios rastreadores de manera habitual para encontrar información. Este hecho es necesario tenerlo en cuenta ya que cada uno de estos crawlers suele centrarse en un tipo de información: noticias, imágenes, vídeo, mobile, etc.. En el siguiente enlace podréis encontrar una tabla en el que están enumerados todos los rastreadores de Google.

Ahora si… ¿Qué es el crawl Budget?

Ahora que todo el mundo sabe cómo funcionan los buscadores, podemos dar un paso más. Aunque pueda parecer mentira, los recursos de Google son finitos. Por este motivo, Google asigna a sus rastreadores un tiempo, en adelante crawl budget, para rastrear cada sitio web. Y he ahí el quid de la cuestión. En base a la autoridad, accesibilidad, calidad y velocidad del site Google asignará más o menos tiempo para que esos robots rastreen sus diferentes páginas.

Y ahora la pregunta del millón.

¿Por qué es importante el crawl Budget para SEO?

Se puede llegar a dar el caso de que el crawl Budget que Google asigna a sus rastreadores para crwalear un sitio web no sea suficiente para que estos visiten de manera regular algunas páginas del site. Si este hecho se produce, lo más probable es que estas páginas no posicionen tan bien como nos gustaría ya que, según nuestra experiencia, hemos podido observar que aquellas páginas que son rastreadas más a menudo reciben más tráfico orgánico que aquellas que no reciben la visita de Googlebot. Tened en cuenta que, si esto pasa con páginas que son vitales para el negocio, tendremos problemas.

¿Cuándo es recomendable trabajar el Crawl Budget?

Según fuentes oficiales de Google:

En webs pequeñas, es decir, de menos de 100 páginas, no es necesario centrarse en trabajar este aspecto, ya que Google tiene recursos de sobras para procesar este tipo de páginas.

Según nuestra experiencia, recomendamos optimizar el Crawl Budget para páginas de más de 5.000 URLs o en aquellas en las que se generen de manera masivas páginas con parámetros, por ejemplo.

¿Cuál es mi Crawl Budget?

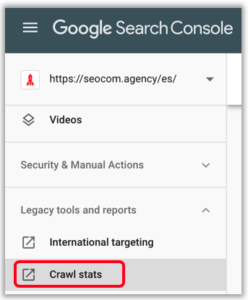

Para conocer tu Crawl Budget, Google Search Console es tu mejor aliado. Basta con acceder al Informe de Crawl Stats a través del menú lateral de tu propiedad:

Al acceder os aparecerá un informe como este:

A continuación os dejamos un recurso oficial que explica cada una de estas métricas en detalle, pero, el gráfico más importante de los tres es el de «pages crawled per day». Basta con comparar este KPI contra el número de páginas de vuestro site (hacer también lo mismo pero solo contra el número de páginas relevantes para vuestro negocio) para saber si hay un problema o no. Si se crawlean menos páginas de las que tiene vuestro site, ha llegado el momento de ver que pasa

¿Cómo auditar mi Crawl Budget?

La manera más fácil de auditar vuestro Crawl Budget es a través del análisis de logs, ya que estos nos permiten saber en todo momento cómo interactúan los rastreadores de Google con nuestro sitio web.

Existen varias formas de analizar los logs pero, a grosso modo, las dos más habituales son:

- A través de herramientas ya preconfiguradas: Screaming Frog File Log Analyzer o Botify

- Crear una herramientas propias a través de otras herramientas como podrían ser: Kibana, Elastic Search, Big Query, Datastudio,…

Si estás empezando con todo lo que tiene que ver con los logs y su análisis, te recomendamos que empieces Screaming Frog Log Analyzer, ya que, con un breve set up, tendrás unos informes excelentes que te permitirán sacar conclusiones.

Cuando estés trasteando los logs, intenta resolver preguntas como:

- ¿Cada cuánto visita Googlebot mi web?

- ¿Qué páginas o secciones visita más?

- ¿Qué páginas o secciones no visita?

- ¿Cuánto tarda en descargar cada tipo de página?

- ¿Qué páginas demanda y dan errores?

Aplicando el sentido común y respondiendo estas preguntas seguro que ya encuentras cosas que no están bien, como por ejemplo:

- Google está destinando tiempo de rastreo a páginas con errores 4xx

- Hay secciones o páginas que tienen un protagonismo muy algo en cuanto a rastreo ser refiere, pero no es representaivo en cuanto a negocio.

¿Cómo aumentar mi Crawl Budget?

Ahora que ya tienes toda la información necesaria, toca arremangarse y ponerse manos a la obra. Para mejorar el rastreo basta con:

Velocidad de carga

Esta es fácil, si tu web carga más rápida, Googlebot podrá rastrear más páginas con el budget designado.

Optimización vía robots.txt

Asegurate de dirigir a Googlebot hacía aquellas secciones que sean prioritarias a nivel de negocio y evita que rastree aquellas que no aportan.Sobre este tema tenéis un tutorial super completo en este vídeo.

Cadenas de redirecciones, errores, sitemaps.xml y control de etiquetas

Debemos asegurarnos que nuestro sitio está bien organizado y que no hacemos perder el tiempo a Googlebot en:

- Etiquetas canonical mal puestas o contradictorias

- Sitemaps que contienen páginas con errores, redirecciones o bloqueadas

- Enlazado interno apuntando a páginas con errores, redirecciones o bloqueadas

- Bucles de redirecciones

- Bloquear vía meta robots de páginas importantes

Contenido pobre o duplicado

Es vital reducir o gestionar muy bien el contenido pobre y/o duplicado de tu site. Hay que evitar que Googlebot dedique recursos a páginas que no aportan nada,como por ejemplo:

- Facetados o páginas con parámetros

- Páginas de productos en diferentes tamaños, formatos, …

- Páginas hackeadas

- Productos discontinuados

Aumenta tu autoridad

Finalmente, la autoridad juega un papel clave. Es muy recomendable activar una campaña de relaciones públicas para que terceros hablen de nosotros

Casos de éxito relacionados con el Crawl Budget

Crawl Budget Optimization for classified websites

Experimentos relacionados con el Crawl Budget

Ready, Set, Go! Googlebot Race