Usando APIs para conectar Google Search Console con ScreamingFrog

Esta es la segunda guía sobre Google Search Console (GSC). Mientras que la anterior se enfocaba en usar Search Console para el análisis de palabras clave, este artículo se centra en utilizar la herramienta para realizar una auditoría técnica de SEO de tu dominio.

Como Olga Zarr describió en su artículo, es posible auditar tu dominio usando solo GSC. Esto se puede hacer utilizando las funciones listadas en GSC:

Sin embargo, la belleza de las APIs es permitirte combinar varios datos. Usar GSC con un rastreador como ScreamingFrog (SF) te permite obtener una visión más amplia de cualquier problema técnico y optimización. ScreamingFrog tiene un artículo junto con un video que explica cómo conectarse a las APIs de Google Search Analytics y URL Inspection y extraer datos directamente durante un rastreo.

Nota: Los Datos Estructurados serán cubiertos extensamente y por separado en otro artículo.

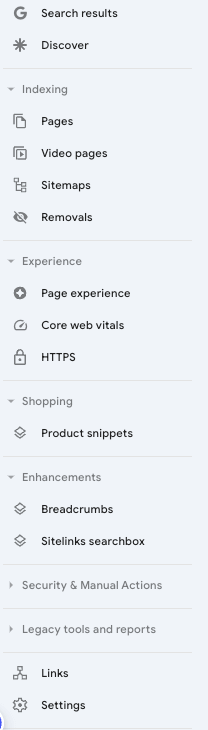

Indexación de páginas vs. páginas no indexadas

Páginas

Revisa el número de tus páginas HTML indexables en SF contra las páginas indexadas en GSC. Exporta ambas listas y compáralas en una hoja de Excel para identificar cuáles URLs GSC no está indexando, pregúntate si son valiosas y si deseas que sean indexadas.

No te preocupes si hay páginas que no son indexables: cada dominio tiene páginas no indexadas en su GSC. Lo que quieres asegurar es que no haya páginas valiosas que se queden sin ser indexadas.

Además, revisa la lista de no indexadas y las razones por las que no están indexadas. Para las URLs listadas como Página con redirección y No encontrada (404), abre tu rastreo en SF y ve a Exportaciones Masivas > Códigos de Respuesta > y exporta el Reporte de 4xx y 3xx. De esta manera, identificarás de dónde provienen los enlaces que apuntan a tus URLs 3xx y 4xx. Poder encontrar de dónde están vinculados estos enlaces te permite saber cómo el bot encuentra estos enlaces y eliminarlos.

Presta especial atención a «Rastreada – actualmente no indexada». Podrías encontrar URLs de parámetros que puedes excluir del rastreo editando tu archivo robots.txt.

Sin embargo, si tienes URLs valiosas que deberían ser indexadas y no lo están, es posible que debas revisar la calidad de tu contenido. Uno de los problemas más frecuentes que llevan a páginas no indexadas es la baja calidad: refresca tu contenido asegurándote de que haya enlaces internos con el ancla correcta apuntando a la URL.

Recuerda que, como dijo John Mueller, «es normal que el 20% de un sitio no esté indexado«.

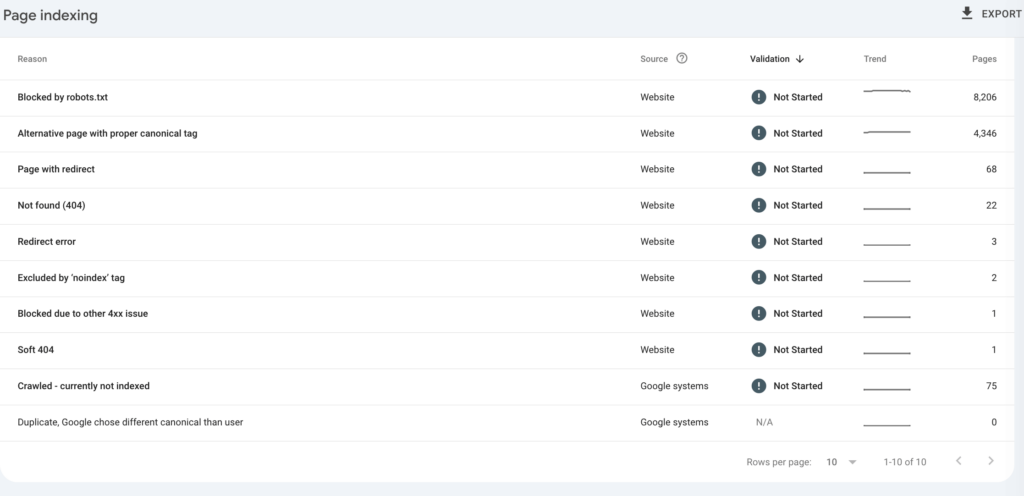

Videos

Es muy frecuente que GSC informe «Los videos en las páginas no están indexados» con la razón «El video no es el contenido principal de la página».

A partir de diciembre de 2023, la documentación de Google cambió para decir «Los videos que no son el contenido principal de la página aparecerán como ‘No se indexó ningún video’ en Search Console».

Por lo tanto, evalúa si en tus páginas el video es el contenido principal de la página; si no lo es, es probable que no se indexe, según lo indicado por la documentación de Google.

Sitemaps

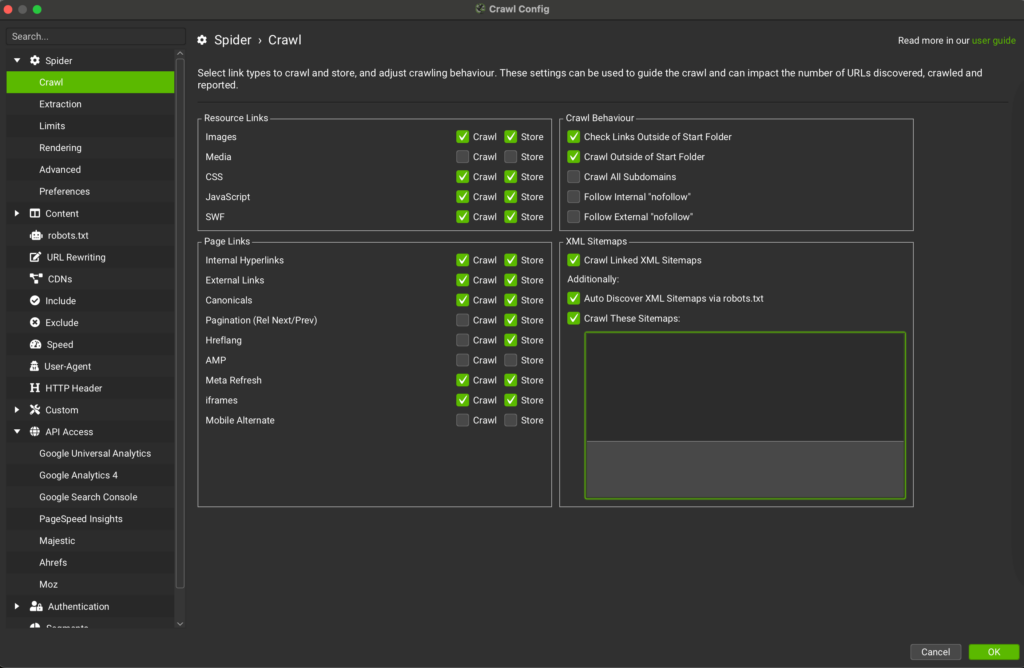

Antes de rastrear con SF, usa la URL del sitemap para agregarla al rastreador. SF te ayudará a analizar errores en las URLs de tu sitemap, como si tienes URLs https no 200 en tu sitemap.

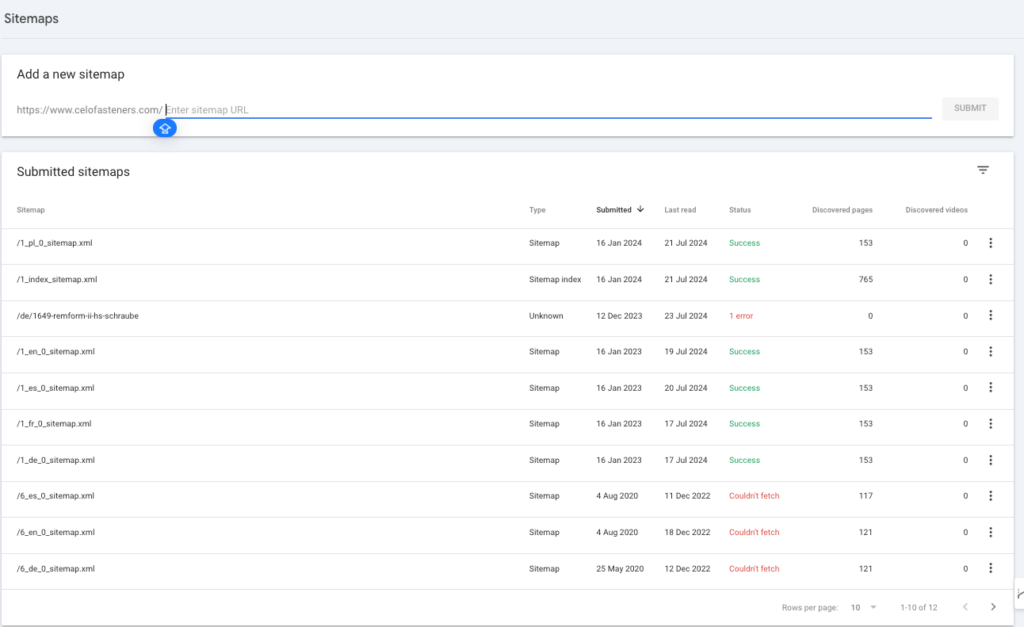

GSC te permitirá saber si hay algún error al recuperar el sitemap. Abre y revisa los sitemaps y complementa SF para auditar tu sitemap. Si tienes varios sitemaps que se han agregado con el tiempo, elimina los antiguos y los innecesarios.

Eliminaciones

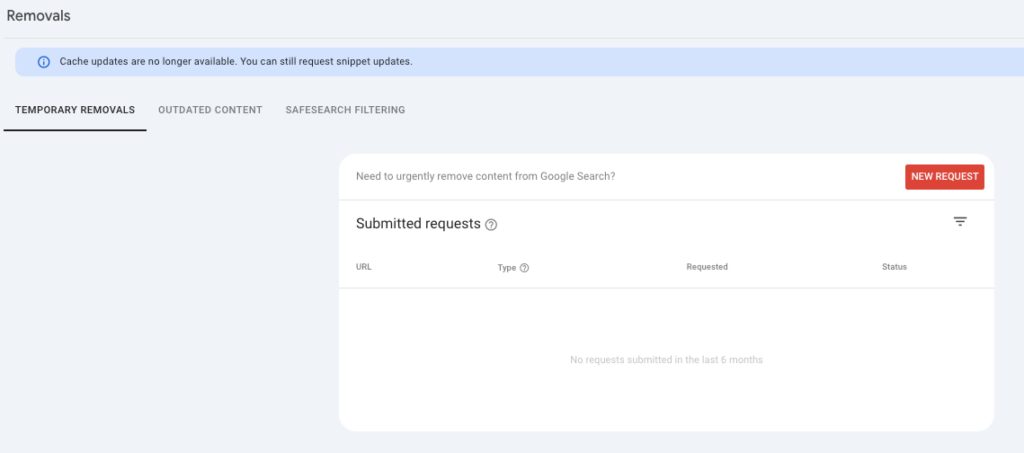

En mi experiencia, nunca he visto una notificación de Google en la sección de Eliminaciones. Esta sección también se puede usar para eliminar las URLs de tu sitio del índice. ContentKing tiene un artículo completo sobre «Cómo eliminar URLs de Google Search rápidamente».

Una vez que comienzas a auditar el dominio por primera vez, esta sección debe revisarse para determinar si se han enviado alguna de estas solicitudes y, de ser así, entender la intención detrás de ellas.

Experiencia de la página

Como afirmó Rick Viscomi del equipo de Chrome Web Performance en el episodio 71 del podcast «Search Off The Record», la principal diferencia que se debe tener en cuenta para los Core Web Vitals es que los datos en GSC son datos de campo que describen la experiencia real de los usuarios con el dominio. Por lo tanto, cuando analizas el rendimiento de una URL en tu computadora, recuerda que tus usuarios podrían tener una experiencia diferente en términos de rendimiento de la página a la que ves, tanto en términos de experiencia como de valores adecuados de Core Web Vitals.

Por lo tanto, como dice Rick Viscomi, si bien solo el rendimiento de tus Core Web Vitals (CWV) no llevará a una caída en el tráfico de tu sitio, por otro lado, estos datos deben analizarse completamente. Y se debe dar más prominencia a los datos de campo de tus usuarios sobre los datos de laboratorio (tus pruebas de CWV en tu laptop).

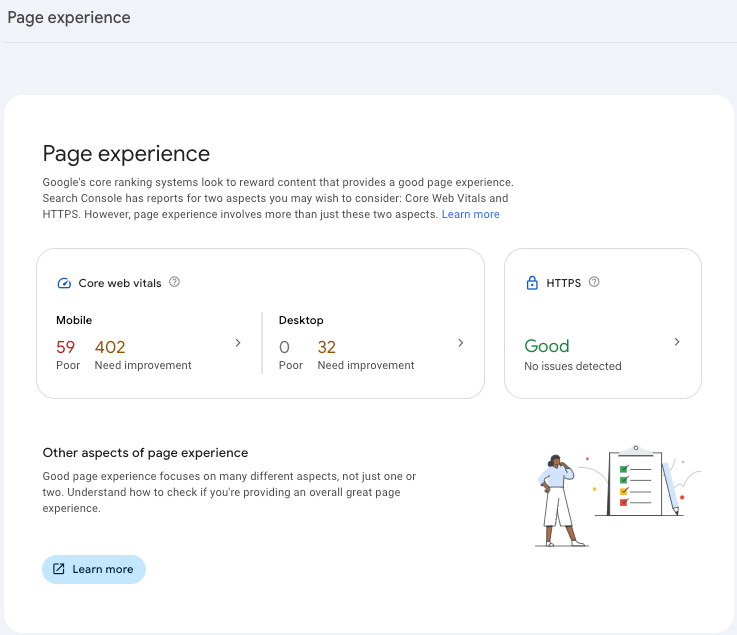

La sección de Experiencia de la página te permite saber cuál es la experiencia del usuario cuando navega por tu sitio: ¿es rápido? ¿Tienen elementos e imágenes moviéndose por toda la página mientras esperan que se cargue (lo que denotaría un problema de cambio de diseño de contenido)?

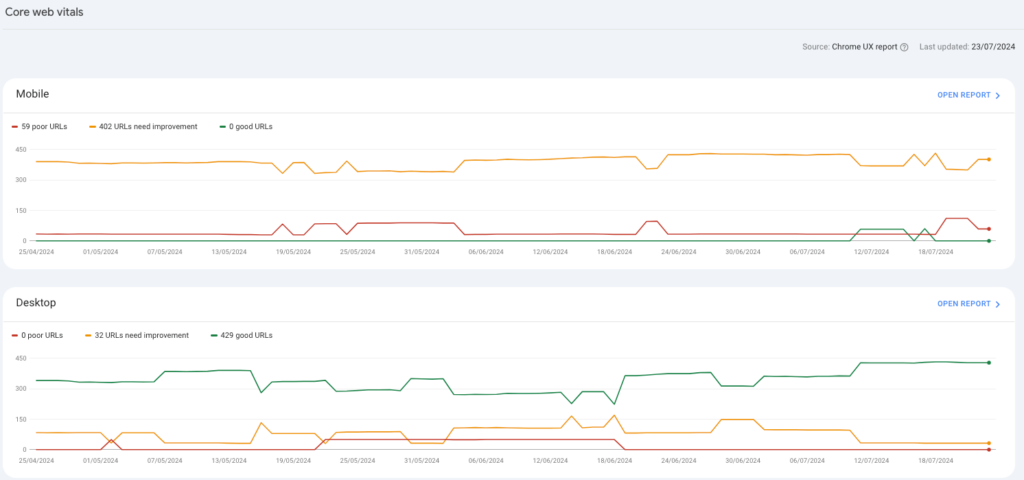

Experiencia de la página y Core Web Vitals

La primera sección, la llamada «Experiencia de la página», te da una visión general de los CWV. Desde allí o desde la siguiente sección, la llamada Core Web Vitals, puedes profundizar en el rendimiento móvil y de escritorio.

Si hay URLs deficientes, abre el informe, selecciona el problema y verifica las URLs en este grupo. Presta atención a si todas las URLs pertenecen a la misma plantilla; si es así, podrías querer hablar con tu equipo de desarrollo para evaluar el problema a nivel de plantilla.

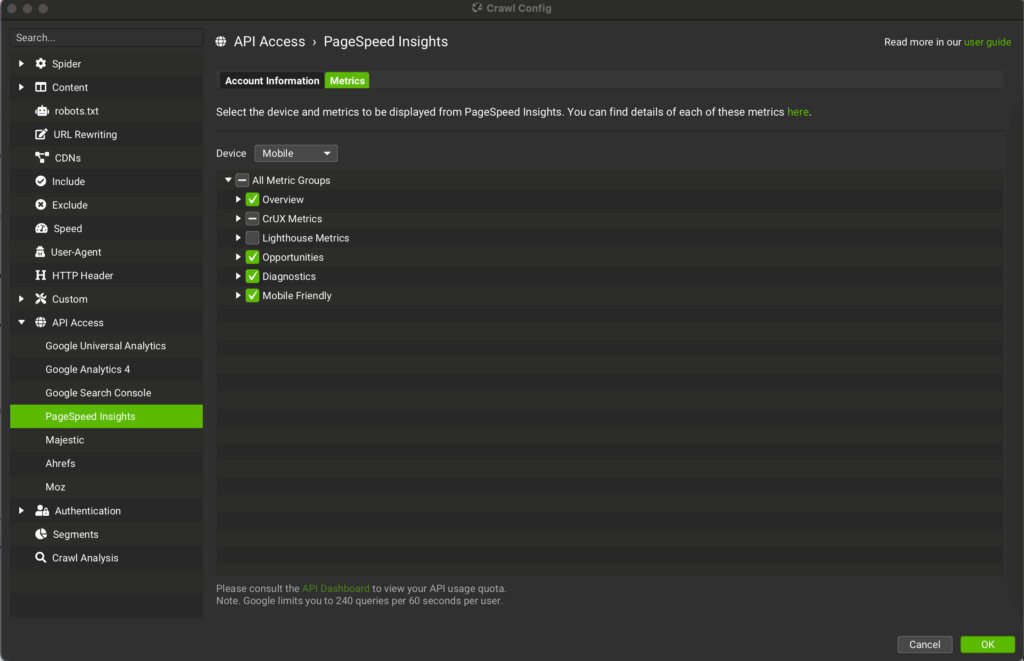

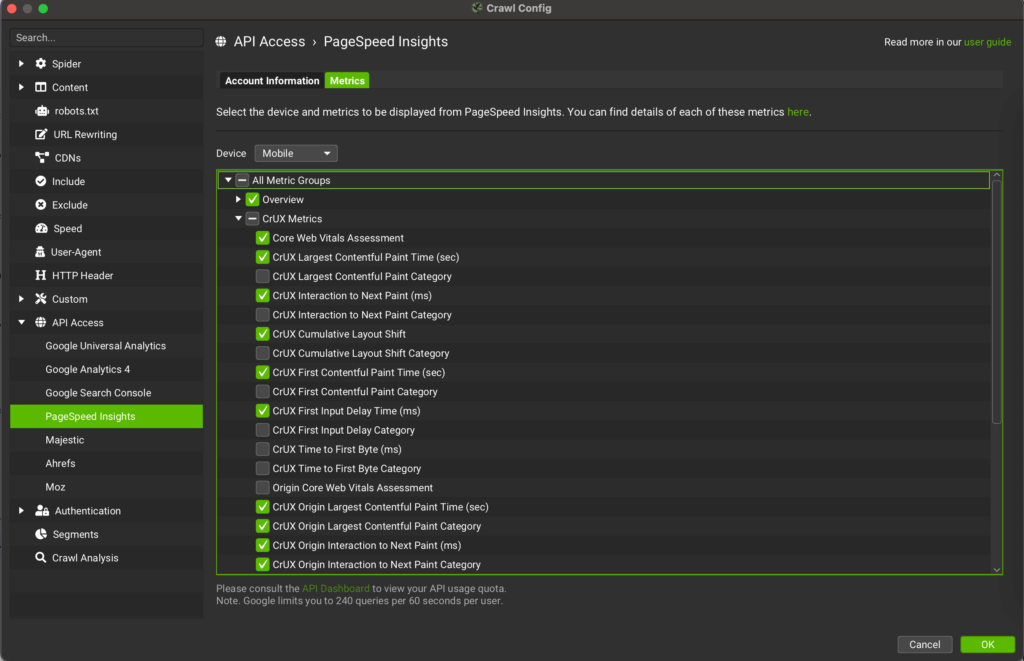

Mientras tanto, usa las configuraciones de SF para obtener más datos rastreando el dominio. Para hacerlo, ve a SF, selecciona «Acceso API» y conecta «Page Speed Insights». Según los problemas reportados por GSC, selecciona los datos en «Métricas». Lo que debería seleccionarse son las métricas CrUX (datos de campo) relacionadas con el problema que has detectado en GSC.

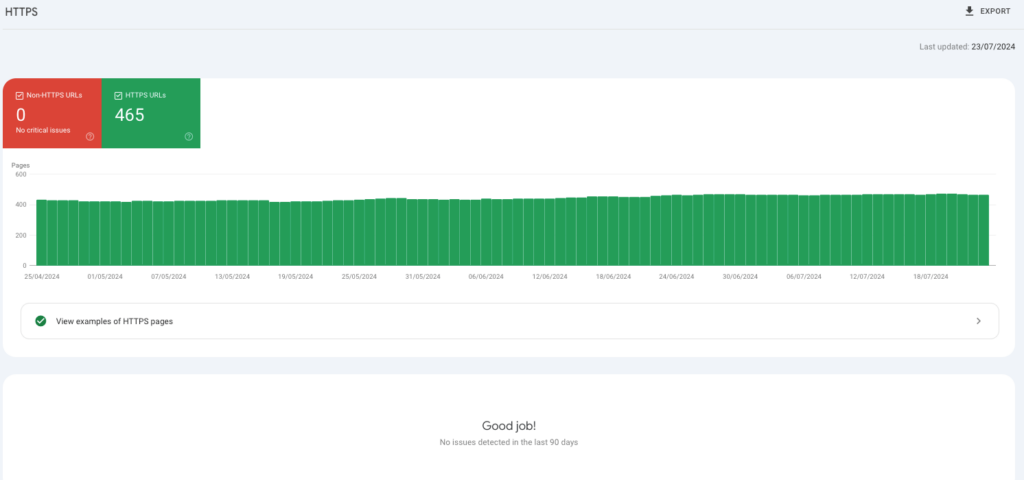

HTTPS

Aunque en mi experiencia nunca me he encontrado con un dominio que tuviera esta sección marcada con URLs no https, si encuentras alguna URL no https, debes asegurarte inmediatamente de resolver este problema. Esto también será señalado por SF, que además de las URLs HTML también señalará cualquier otra URL, ya sea imagen o cualquier otro elemento no https. Todas las URLs deben ser https: los usuarios no confiarán en una no https y Google la señalará a los usuarios si llegan a ella.

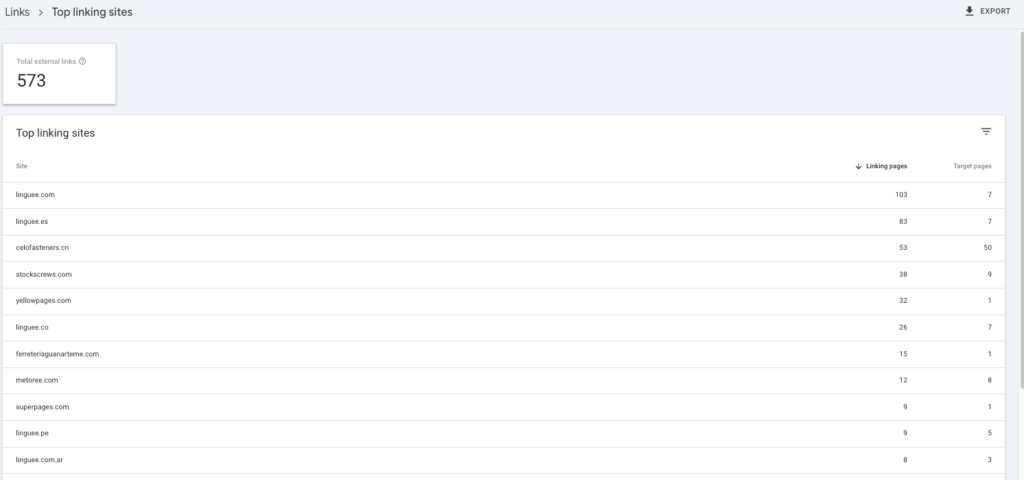

Enlaces

Basado en mi experiencia, la sección de enlaces, aunque vale la pena revisarla, puede ser analizada de manera más profunda con rastreadores. El único consejo es revisar los Sitios de enlace principales para asegurarte de que no haya dominios de spam allí.

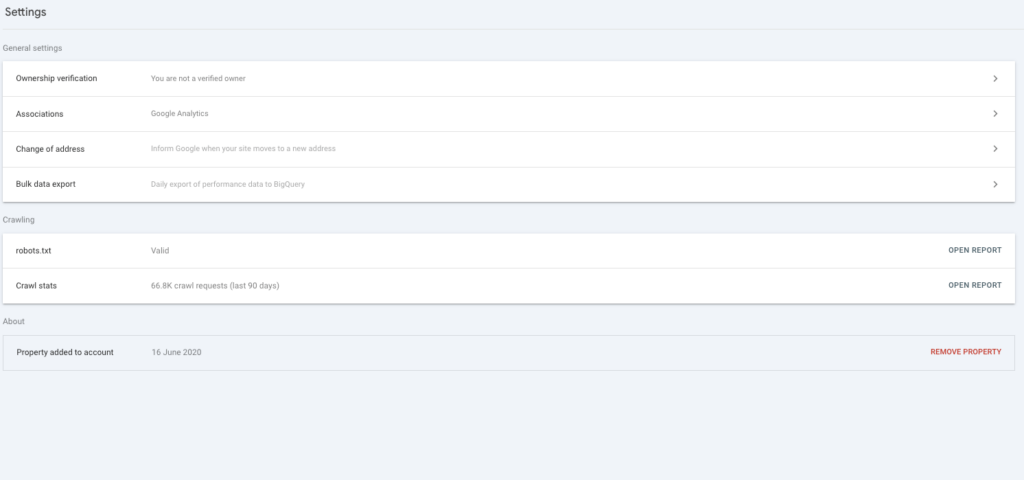

Configuraciones

Esta es una de las partes más importantes de GSC y debe revisarse regularmente. Las 2 partes relevantes son:

- Robots.txt

- Estadísticas de rastreo

Robots.txt

Abre el informe y asegúrate de que el estado del robots txt sea «Extraído». Si no es así, revisa inmediatamente el archivo txt para entender qué está pasando y da máxima prioridad a resolverlo.

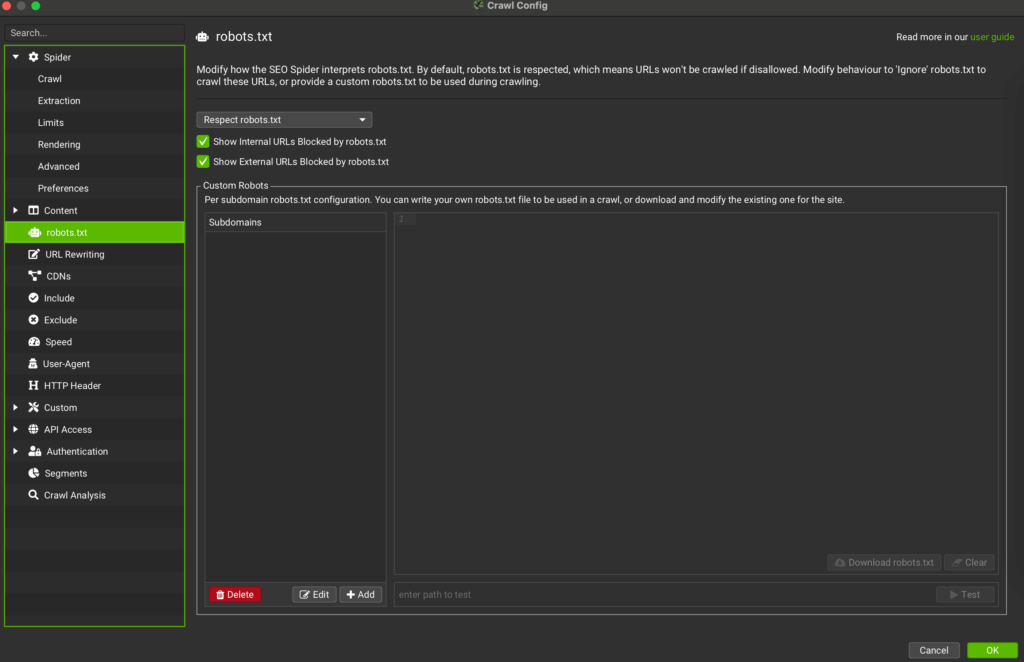

Abre el enlace de tu archivo robots txt desde allí y revísalo. Como consejo, copia y pega el contenido en otro documento de texto o Word. Luego ve a SF y revisa un conjunto de tus páginas bloqueadas por robots. Si hay páginas que consideras relevantes y quieres que sean rastreadas, edita el documento donde copiaste tu archivo robots txt.

Pega la nueva versión de tu robots txt en SF, en la sección homónima, y pega una URL en el campo llamado «Test». Esto te permitirá entender los cambios hechos en el robots txt y cómo impactarán en el comportamiento de los bots.

Como explicó Mark Williams-Cook, fundador de AlsoAsked, «Contrario a la creencia popular, agregar páginas al robots txt no detiene que sean indexadas. El robots txt controla el rastreo, no la indexación». Ten esto en cuenta mientras trabajas en tu archivo txt y mientras auditas tu dominio.

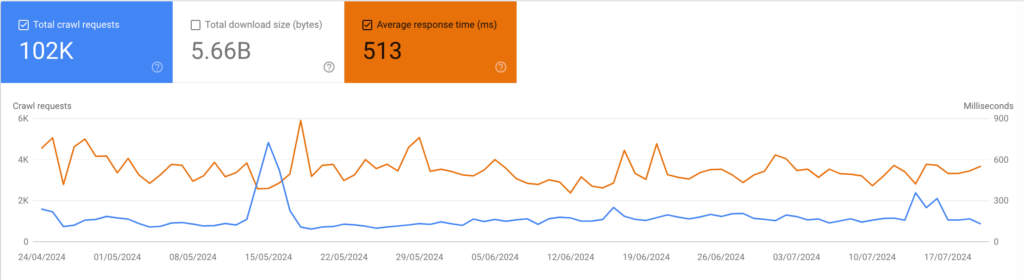

Estadísticas de rastreo

En el informe de estadísticas de rastreo, selecciona el Tiempo de respuesta promedio. Lo que debería preocuparte son:

- Aumento del tiempo de respuesta promedio: si hay un claro aumento desde una fecha, asegúrate preguntando al equipo de desarrollo si se hizo una migración de servidor el mismo día del aumento. O si se añadió alguna plantilla o plugin al CMS. Recuerda: el tiempo de respuesta es medido por Googlebot desde los EE. UU. Por lo tanto, si hubo una migración de servidor a un servidor en otro país para asegurar que los usuarios en el país objetivo obtengan mejor rendimiento, podrías notar paralelamente una disminución en el tiempo de respuesta promedio. En resumen, quieres reducir lo más posible el tiempo de respuesta promedio.

- Disminución de las solicitudes totales de rastreo: profundiza para entender qué archivo y tipo de respuesta es el que ha llevado a menos solicitudes de rastreo. Si tu sitio no está actualizando el contenido, podría ser que Google lo esté revisando con menos frecuencia. Debes buscar aumentar la frecuencia de rastreo para dar una señal de contenido fresco a Google.

Si durante el mismo día el tiempo de respuesta promedio aumentó abruptamente mientras que tus solicitudes totales de rastreo disminuyeron, es posible que Google haya rastreado tu sitio y lo haya encontrado lento, ya sea debido a un ataque DDOS o porque estaba ralentizado por varios usuarios al mismo tiempo. En cualquier caso, quieres asegurarte de que esto no vuelva a ocurrir. Googlebot podría comenzar a rastrear tu sitio con menos frecuencia para evitar sobrecargarlo, pero esto significará que el bot notará con menos frecuencia el contenido actualizado y tomará más tiempo para indexar el nuevo contenido.

Reflexiones finales

Si quieres obtener una visión más amplia sobre cómo funciona GSC, Anna Crowe publicó recientemente un artículo en Search Engine Land.

Mientras que GSC ofrece valiosos conocimientos, combinarlo con SF permite un análisis más completo. SF rastrea tu sitio web, identificando problemas técnicos que GSC podría pasar por alto.

En conclusión, mientras que Google Search Console ofrece una gran cantidad de datos de SEO, usarlo junto con Screaming Frog desbloquea una auditoría técnica de SEO más poderosa. Al combinar los conocimientos de GSC con las capacidades de rastreo de SF, obtienes una visión completa de la salud de tu sitio web, identificando y abordando posibles problemas que podrían estar obstaculizando tu clasificación en los motores de búsqueda.