A finales de noviembre de 2020 Google lanzó una nueva versión del informe “Estadísticas de rastreo” que viene para sustituir al antiguo informe de Search Console.

Esta nueva herramienta sin duda nos ofrece mucha mas información acerca de cómo los bots de Google rastrean nuestro sitio web y otros aspectos un poco más técnicos que nos pueden ayudar a optimizar el crawl budget de nuestro sitio web.

Como si se tratara de una pequeña auditoria SEO para ver el estado de salud de nuestro site.

Cuanto más grande sea tu proyecto web, más provecho le sacarás a esta herramienta, ya que podrás sacar más conclusiones y tener información mucho más detallada.

A lo largo de este artículo veremos cada una de las nuevas funciones que incluye este nuevo informe, también llamado “Crawl Stats”.

Te dejamos el enlace al informe para que puedas acceder directamente e ir revisando los apartados a medida que vas leyendo nuestro artículo:

También puedes acceder desde tu cuenta de Search Console, desde la pestaña Ajustes > Rastreo > Abrir informe.

Primeras impresiones del nuevo informe

Esta es la nueva gráfica que nos presenta este nuevo apartado, donde podemos ver por defecto las solicitudes de rastreo que se han enviado a nuestro sitio web durante el período indicado, que suele ser de los últimos 3 meses.

Las otras dos métricas disponibles son:

- Tamaño total de la descarga: te indica el tamaño en bytes de los principales recursos descargados durante cada rastreo: html, imágenes, css, etc.

- Tiempo medio de respuesta: puedes visualizar el tiempo medio que se tarda en obtener todo el contenido de una página.

Si hay alguna actualización en la búsqueda de Google, también lo verás indicado en la gráfica en la fecha donde haya sucedido esta actualización:

Estado de los Hosts

Desde este apartado podrás ver de forma genérica cuales de tus dominios principales o secundarios han tenido problemas de servidor y se han caído en algún momento.

Si quieres ver los datos de algún dominio en particular, con hacer clic encima de este será suficiente para filtrar solamente la información de rastreo ese dominio, de lo contrario, se reflejarán los datos de forma general para todos ellos.

El estado actual de tus dominios lo podrás ver gracias a los iconos que vemos de forma gráfica en un lateral. Si has tenido alguna caída de servidor u otro problema relacionado con el rastreo de Google, verás el icono en color rojo.

Agrupaciones de solicitudes de rastreo

Con estos nuevos datos ya podemos sacar mejores conclusiones y ver algunos de los problemas que nos pueden afectar más en optimizar el crawl budget.

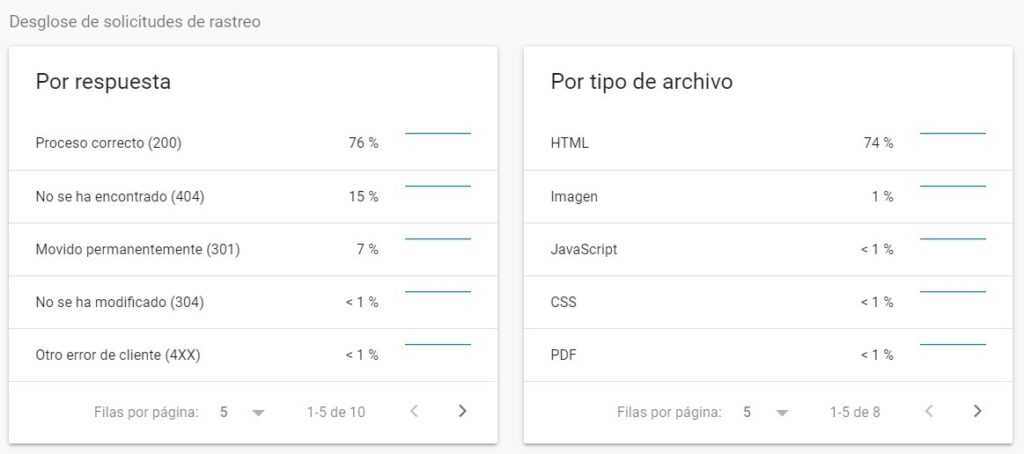

Solicitudes por respuesta

Como podemos ver, en esta agrupación podemos visualizar en porcentaje todos los códigos de respuesta que devuelven nuestras URLs del sitio web.

Los ejemplos que podemos ver son algunas muestras de los problemas que ha encontrado Google en nuestro servidor.

De momento no tenemos opción de sacar el listado completo, por lo que tendremos que conformarnos con ello. Igualmente, nos sirve como guía para saber con qué casuísticas nos encontramos, y a medida que lo vayamos corrigiendo, si existen más, aparecerán listadas.

Dentro de estos códigos tenemos diferentes respuestas que podemos agrupar en:

Proceso correcto (200): Páginas que actualmente están funcionando y no representan ningún problema, ya que son las URLs que tenemos activas en nuestro sitio web.

Movido permanentemente (301): Páginas con una redirección actual hacia otras páginas. No suponen un problema siempre y cuando no se abuse de ellas. Es muy frecuente ver este tipo de respuestas en migraciones SEO, de lo contrario, deberíamos intentar minimizar la cantidad de redirecciones para que Google no tenga que procesar tantos cambios.

Si tienes un e-commerce, estoy seguro de que te preguntas como gestionar las redirecciones en los productos que ya no tengas en stock. En este artículo te explicamos como gestionarlo.

Por lo general, la mayor cantidad de porcentaje dentro de este apartado debería aparecer en la agrupación de páginas con una respuesta de código 200.

No se ha encontrado (404): Este es el tipo de páginas que debemos evitar tener en nuestro sitio web, y a través de este informe podemos corregir una gran cantidad de errores.

Si accedes dentro de este apartado, verás el listado de 404 con la fecha en la que se encontró esta URL. Ve revisando de forma periódica este listado para reducir tus errores hasta que el mayor porcentaje de páginas por respuesta tengan un código 200.

Estas 3 agrupaciones de códigos de respuesta suelen ser los más comunes, no obstante, también pueden aparecer otros errores, tales como: los DNS no responden, archivo robots.txt no disponible, movido temporalmente (302) e incluso errores de servidor (500).

Solicitudes por tipo de archivo

Tal y como indica el nombre, Google también nos diferencia los recursos de nuestro sitio web según el tipo de archivo.

La mayor parte de este porcentaje debería estar en los archivos HTML, ya que son los que nos interesa que Google rastree debido a que se trata de las páginas de nuestro sitio web.

El resto de archivos (JCSS, JavaScript, PDF…) deberían ser un porcentaje muy bajo en comparación a los archivos HTML.

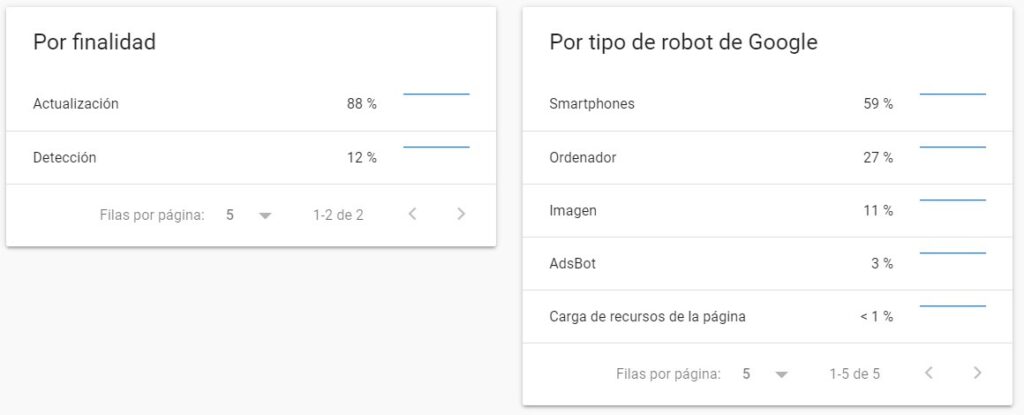

Solicitudes por finalidad

En este apartado podemos ver únicamente dos opciones:

Actualización: El bot de Google detecta páginas que ya están creadas y que han sufrido alguna actualización, ya sea por cambios de contenidos u otras modificaciones.

Detección: Google ha detectado páginas nuevas en nuestro sitio web.

No existe un porcentaje ideal para cada uno de ellos, pero lo que sí nos interesa, es que Google vaya rastreando contenido actualizado en la web con el objetivo de aumentar el crawl budget. Cuanto mas contenido nuevo hagas mejor.

Solicitudes por tipo de robot de Google

¿Qué bot está rastreando más nuestro sitio web?

Desde este apartado podremos conocer la frecuencia con la que nos visitan los diferentes bots de Google.

El que mayor porcentaje recibe debería ser el de Smartphones, debido al mobile first indexing. Y dependiendo del tipo de proyecto web que tengas, o bien le seguirá el Googlebot de Desktop (ordenadores) o el de Imágenes. También puedes encontrarte con el Adsbot, destinado para Google Ads.

Conclusiones de la nueva herramienta de Crawl Stats

Sin duda esta nueva herramienta nos aporta una excelente visión de algunos datos que podemos aprovechar, como solucionar errores 404, detectar redirecciones 301, ver que tipo de robot está visitando más nuestro sitio web… y todo ello sin la necesidad de hacer un análisis de logs.

Como ya he comentado anteriormente, Google no nos ofrece todos los datos que necesitamos, sino que nos proporciona simplemente una parte para que vayamos corrigiendo estos errores poco a poco. Aun así, creemos que se trata de una herramienta que nos va a permitir corregir muchos de los problemas que antes no podíamos visualizar sin tener unos conocimientos técnicos mínimos.