En este artículo te contamos todo lo que necesitas para entender la importancia y cómo se lleva a cabo una auditoría SEO.

Si decides llevarla a cabo por tu cuenta, tendrás una buena guía de base, pero si buscas a una agencia profesional para tu auditoría SEO, entonces no dudes en contactarnos y con gusto te explicaremos lo que podemos hacer por tu negocio.

Hablamos?

La auditoría SEO es el pilar de cualquier proyecto de posicionamiento web que deseemos trabajar. Es donde analizaremos a fondo la página web para encontrar todos los errores y posibles mejoras que ayudarán a nuestro proyecto a mejorar su posicionamiento, consiguiendo así atraer un mayor número de clicks y ventas en el canal orgánico.

Realizar una auditoría SEO no es tarea fácil, requiere de mucho tiempo, esfuerzo y una gran atención por el detalle, ya que en el mundo del SEO, hay muchos factores que nos pueden ayudar a sumar puntos para un mejor posicionamiento. Y esto en SEOCOM.Agency lo sabemos muy bien, ya que auditamos muchas webs de clientes que deciden confiar en nuestra experiencia.

No existe una metodología única para llevar a cabo este análisis SEO, aun así, vamos a intentar detallar al máximo todos los aspectos que consideramos de vital importancia para mejorar la visibilidad de cualquier proyecto.

Pero antes, vayamos más a detalle sobre lo que es una auditoría SEO y para que nos sirve.

¿Qué es una Auditoria SEO y por qué es tan importante?

Una auditoría SEO es un análisis exhaustivo que evalúa un sitio web para identificar las fortalezas, debilidades y áreas de mejora en términos de optimización para motores de búsqueda (SEO, por sus siglas en inglés). El objetivo principal es mejorar la visibilidad del sitio en los resultados de búsqueda orgánica, aumentando el tráfico y, en última instancia, mejorando la conversión y el rendimiento general del sitio web, por este motivo, buscaremos todos los fallos y mejoras en nuestra pagina web. Al final, como su nombre indica, estamos auditando el trabajo que se ha realizado en la página web, para determinar que deberíamos de cambiar para que Google entienda mejor a nuestra web.

Aunque una auditoría SEO, no debería incluir la estrategia SEO, ya que solo estamos auditando, en SEOCOM.Agency trabajamos la auditoría y la estrategia SEO conjuntamente, y el motivo es sencillo, no vemos ningún sentido trabajar una auditoría donde vamos a cuestionarnos todo el proyecto web, la arquitectura, los contenidos, el enlazado,…, sin tener una Estrategia SEO que nos defina el porqué de las cosas.

La estrategia SEO deberá estar acompañada por un proceso de trabajo en el que se tengan en cuenta todos los factores necesarios para trabajar el proyecto como:

-

- Tiempo de implementación por tarea: es necesario tener una planificación en el tiempo de cada tarea para poder cumplir los objetivos en los tiempos definidos.

-

- Responsables de cada tarea. Aquí es importante definir quién se encargará de ejecutar cada parte de la estrategia. Ya que en función de quienes sean los encargados de su ejecución dispondremos de más o menos tiempo para hacer lo que sea nuestra responsabilidad.

-

- Priorización de las tareas: Establecer prioridades es clave, sobretodo al principio del proyecto, el encontrar los Quick-wins nos permitirá trabajar los puntos que más resultados nos darán por el menor coste.

-

- Calendario de trabajo: Una vez tenemos todo definido, pasamos a crear un calendario de trabajo en el que definimos qué se trabajará a lo largo de la duración del proyecto.

Herramientas recomendadas para hacer una auditoría SEO

Hay una infinidad de herramientas que se pueden utilizar para analizar webs, aquí listaremos principalmente las que mencionaremos a lo largo del artículo.

|

|

Es una herramienta que rastrea las webs de manera similar a como lo haría un crawler de un motor de búsqueda y nos da una gran cantidad de información sobre todas las URLs que es capaz de rastrear. Es una herramienta bastante avanzada, aunque para uso básico no es excesivamente complicada de utilizar. |

|

|

Es una herramienta de la propia Google, nos aporta bastante información con todo lo relacionado con el canal orgánico y bastante información útil a nivel técnico. |

|

|

Nos aporta toda la información sobre los usuarios y su comportamiento a lo largo de nuestra web. Datos estadísticos de todo tipo que nos servirán para conocer el estado de nuestra web y comportamiento de nuestros usuarios. |

|

|

Herramienta multi usos para prácticamente todo lo relacionado con el SEO. Es especialmente conocida por ser la mejor herramienta para trabajar el Off Page y perfil de enlaces. Pero es una herramienta excelente para hacer seguimiento del estado del proyecto, palabras clave, mejores URLs |

|

|

Mide el impacto de tu estrategia SEO con esta herramienta con múltiples funcionalidades y características. |

Contentking |

Controla el estado de web a tiempo real con esta gran herramienta. Contentking es de las pocas herramientas que te analiza tu web 24/7. |

|

|

Otra herramienta líder en el mercado SEO para llevar un control de marketing y visibilidad de tu proyecto. |

SE Ranking |

SE Ranking monitorea posiciones, analiza la competencia, realiza auditorías SEO, gestiona palabras clave y genera informes detallados para optimizar tu estrategia digital. |

¿Merece la pena hacer una Auditoría SEO?

Si quieres tener tu sitio web optimizado para posicionar en Google, una Auditoría SEO debe ser un acción casi obligatoria. No obstante, es una labor que se ha de realizar de forma periódica para tener un control constante de la evolución del proyecto.

¿Quien debe realizar una Auditoría?

En nuestro post te damos las herramientas necesarias para hacer una Auditoría básica. Otra alternativa pasa por contratar a una agencia experta en este tipo de análisis, la cuál puede entrar en aspectos más detallados que otras personas con menos experiencia no lleguen.

¿Cuáles son los principales factores que debemos analizar?

En nuestro artículo hemos separado nuestro checklist de tareas en dos partes. Un bloque que comprende todos los aspectos SEO On-page y que podemos controlar de forma interna, y otro bloque de SEO Off-page, que ya depende de sitios externos.

Pilares a la hora de hacer una auditoría SEO Básica. On Page y Off Page.

Primero que todo, empecemos con lo más básico. Generalmente, una auditoría SEO se divide en dos partes, la parte On Page, y la Off Page.

Si sabes algo sobre SEO, seguro que sabes distinguir estos dos pilares de forma sencilla, pero en caso de que no, te lo contamos.

-

- On Page: Trata todo lo relacionado con lo que es la propia web digamos. En ella se tratan aspectos de SEO técnico (indexabilidad, rastreo, WPO, sitemap, etc) y Contenidos (meta etiquetas, encabezados, arquitectura web, palabras clave, etc).

-

- Off Page: En este caso trata de temas externos a nuestra web (enlaces entrantes, autoridad, perfil de enlaces, etc)

Una vez sabemos lo que es el On Page y el Off Page. Vamos a analizar distintos aspectos que hay que tener en cuenta en cada una de estas ramas para asegurarnos de que nuestro proyecto está cumpliendo con las directrices recomendadas.

Parte On-Page en una auditoría SEO

Arquitectura

Una buena arquitectura enfocada al SEO es uno de los pilares principales para que una estrategia SEO funcione. Es muy importante que todas las páginas que más nos interese posicionar estén lo más accesibles que podamos, dentro de una estructura lógica y funcional. Una mala arquitectura puede dinamitar todo un proyecto SEO ya que puede perjudicar la rastreabilidad del sitio y por lo tanto su indexabilidad y posicionamiento general.

Explicar como debe ser una arquitectura es imposible ya que cada proyecto tiene sus necesidades. Pero básicamente es crear una estructura de URLs clara, que permita una navegación cómoda por la web, y que se pueda llegar con los mínimos clicks posibles a todas las páginas importantes de la web. De todas formas, tenemos un post con consejos para una arquitectura SEO que te recomendamos leer.

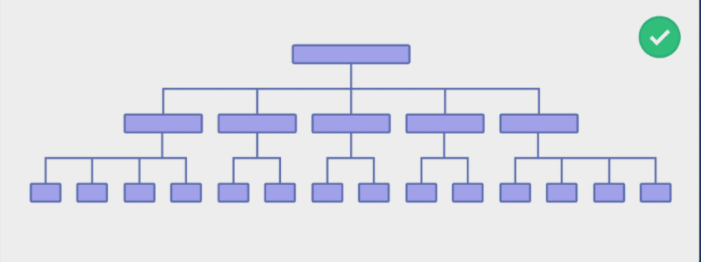

Una arquitectura sencilla se podría ver así:

Aunque obviamente cada proyecto es un mundo y las arquitecturas siempre serán personalizadas según las necesidades del proyecto.

Rastreo

Bueno, ya que mencionábamos el rastreo en el punto anterior, hablemos de ello. Como ya sabrás, Google tiene una serie de robots (crawlers) que se encargan de rastrear las webs, sus URLs y su contenido. Pero van relativamente a ciegas descubriendo enlaces según los van encontrando. Es por eso que es importante que todas las páginas de la web sean fácilmente accesibles, porque de esta forma también serán fácilmente rastreables.

Hay que tratar de facilitarle la tarea a los crawlers lo máximo posible. Por eso una de nuestras recomendaciones es que no haya más URLs que las necesarias, evitar generar páginas que no van a cumplir ninguna función. Tener un exceso de URLs puede provocar problemas de rastreo principalmente por lo que se conoce como Crawl Budget, o Presupuesto de Rastreo en español.

Aunque es cierto que el concepto de Crawl Budget ha cambiado a lo largo de los años expliquemos lo que es. Los crawlers tienen una serie de recursos limitados para rastrear los millones de webs que existen en la red, es por eso que asigna cierto presupuesto a cada web, y cuanto mayor sea más rastreará Google. Pero si Google no considera la web lo suficientemente relevante, la cantidad de URLs que rastreará puede ser menor. Es por eso que por lo general intentamos optimizar la cantidad de URLs que tenemos en una web y asegurarnos que rastree la que de verdad nos importa.

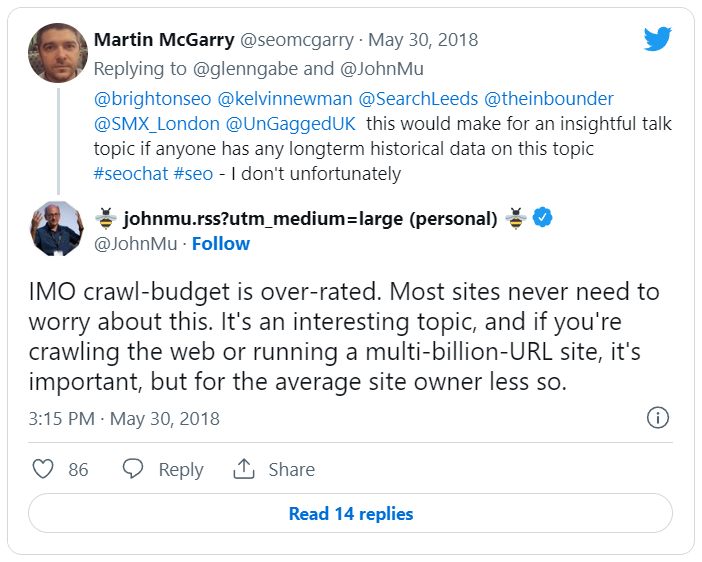

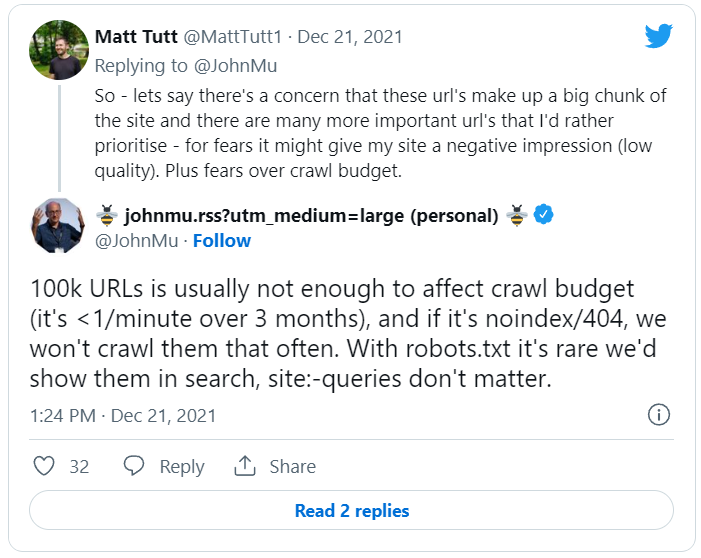

De todas formas, John Mueller ha insistido que realmente no afecta como se creía antes, y que salvo que tengamos una web gigante no debería haber problemas de crawl Budget.

Por lo tanto, a modo de conclusión, importante asegurarnos que las páginas que más nos importan son fáciles de rastrear, que no haga falta que el crawler dé muchos saltos para llegar a ellas, y con eso debería ser suficiente.

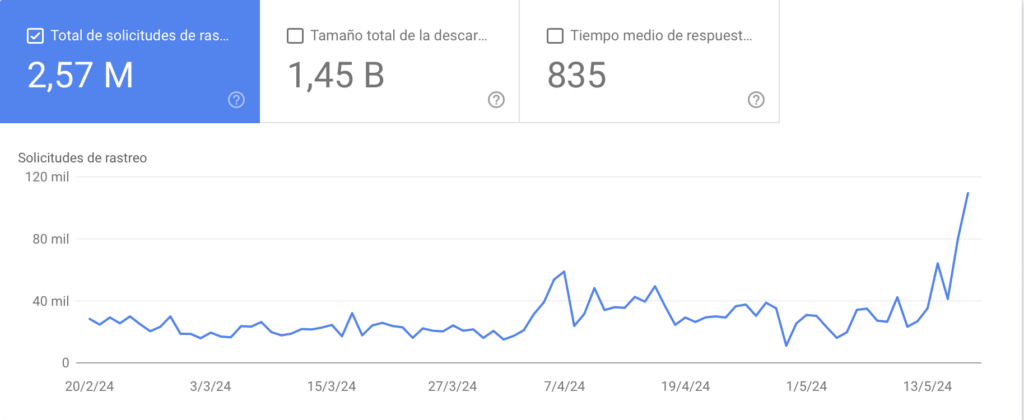

Para saber la frecuencia y la cantidad de URLs que Google está rastreando en nuestro sitio podemos utilizar la herramienta de estadísticas de rastreo de Google Search Console, donde podemos ver un gráfico con los datos de la cantidad de URLs que Googlebot ha rastreado en los últimos 90 días.

Otro consejo que damos para analizar la calidad del rastreo es utilizar Screaming Frog, esta herramienta nos permite ver el Crawl Depth, o profundad de rastreo. Con esto sabemos cuantos enlaces ha debido seguir el rastreador para llegar al destino. Podemos utilizar esta información y cruzarla con las URLs que más nos importan del proyecto y asegurarnos que esas páginas son fáciles de rastrear.

Disallow

Dentro del rastreo, tenemos una directiva que es importante mencionar, y esta es la directiva disallow. La podremos encontrar dentro del archivo robots.txt de una web.

Las URLs y rutas que sigan a una directriz disallow no serán rastreadas por el robot. Es una directiva muy útil para cuando tenemos secciones de la web muy grandes que no queremos que Google rastree porque no cumplen ninguna función a nivel de SEO. Pero hay que tener muchísimo cuidado con como aplicamos esta directiva, ya que si bloqueamos el acceso a lugares importantes podemos dinamitar el proyecto entero. Así que hay que ser muy cuidadosos con esto.

Personalmente, conociendo lo que mencionábamos anteriormente que para tener problemas de rastreo debe haber muchísimas URLs, ya prácticamente no hago uso de la directiva disallow porque lo considero un esfuerzo en vano. Pero es importante conocer sus aplicaciones y usos porque puede hacer falta en cualquier momento.

Indexabilidad

La indexabilidad va de la mano con el rastreo, de hecho, hay gente que confunde ambos términos.

Que una página sea indexable significa que está podrá aparecer listada en los motores de búsqueda. Si la página no es indexable, los usuarios no podrán acceder a ella mediante el canal orgánico y por lo tanto es un desastre para SEO.

Para asegurarnos que la indexabilidad de nuestras páginas es correcta, hay que tener en cuenta varios factores:

-

- La página debe ser rastreable, ya que el motor de búsqueda debe poder encontrarla y poder leer su contenido. Y aquí es donde la gente suele confundir términos entre rastreo e indexabilidad.

-

- La página debe responder correctamente, la página se debe poder cargar y visualizar sin ningún problema. En términos un poco más técnicos, la página debe de tener un código de estado 200 (OK)

-

- La página no debe tener una meta etiqueta no-index.

-

- La página debe ser canónica (Explicación sobre la etiqueta canonical aquí). Esto quiere decir, que la etiqueta canonical de la web no debe enlazar hacia ninguna otra página que no sea la URL misma, también conocido como un canonical self referential.

Una URL puede ser rastreada pero no indexable. Por ejemplo, cuando una página tiene una meta etiqueta no index, Google la rastreará, pero no la mostrará en los resultados de búsqueda.

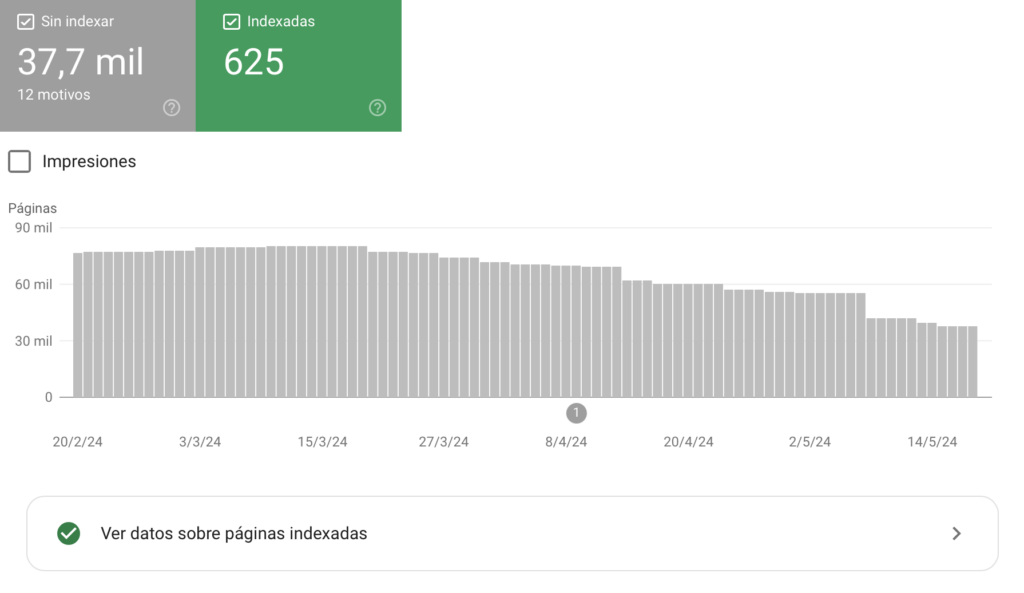

Para conocer el estado de la indexabilidad de la web, te recomendamos hacer uso de la funcionalidad de “Páginas” dentro de la sección indexación de la herramienta de Google Search Console.

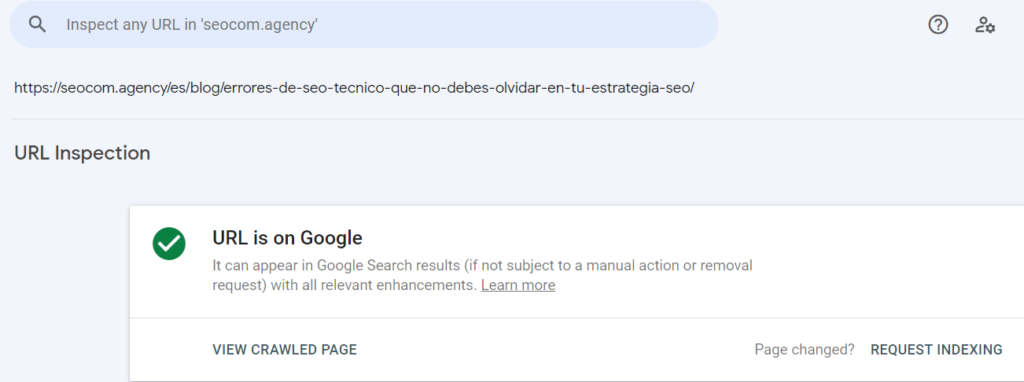

También se puede colocar la URL dentro del inspector de Google Search Console, y este nos dará información relacionada con la URL, si esta está indexada, o si por lo contrario no lo está. Además, si no lo está, tendremos la opción de solicitar a Google que indexe la página, si pulsamos este botón Google testeará la URL, y si es indexable, la indexará.

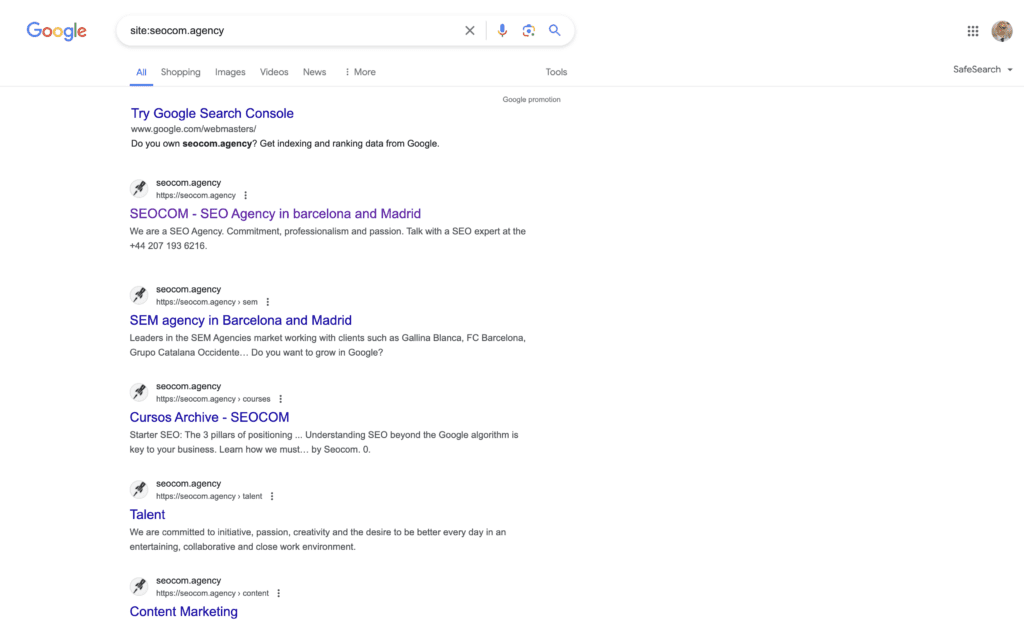

Otro método para conocer si una URL que te interesa está indexada de forma rápida es simplemente hacer una búsqueda en Google pegando la URL y poniendo site: por delante. Ejemplo: site:seocom.agency

Sitemaps y Robots.txt

Sitemap

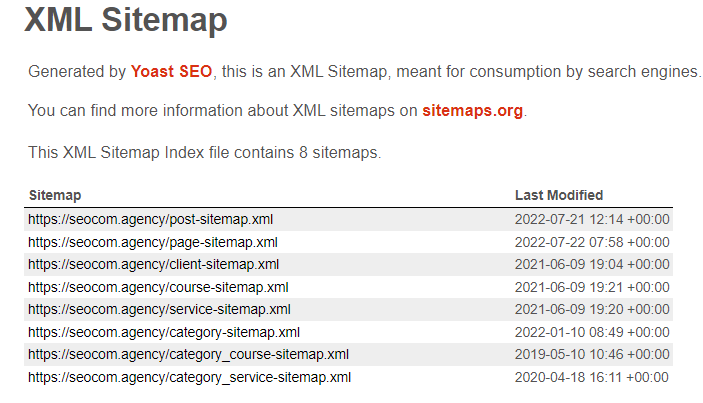

Relacionado tanto con el rastreo como con la indexabilidad, nos encontramos con el sitemap. Este es un archivo que contiene o debería contener todas las URLs que nos interesa que Google rastree e indexe de forma estructurada. No tiene más misterio. Este archivo debe contener todas las URLs que queremos posicionar en un proyecto. Es un archivo que los rastreadores revisan y será muy útil para asegurarnos que nuestras URLs serán rastreadas.

La forma de estructurar un sitemap realmente es prácticamente libre. Se pueden colocar todas las URLs dentro de uno sin ningún orden concreto. Y si queremos ser más organizados lo podemos hacer por idiomas, secciones de la web… Esto lo solemos hacer cuando la web es muy grande, pero realmente a los rastreadores les da bastante igual porque rastrearán las URLs de manera indistinguible.

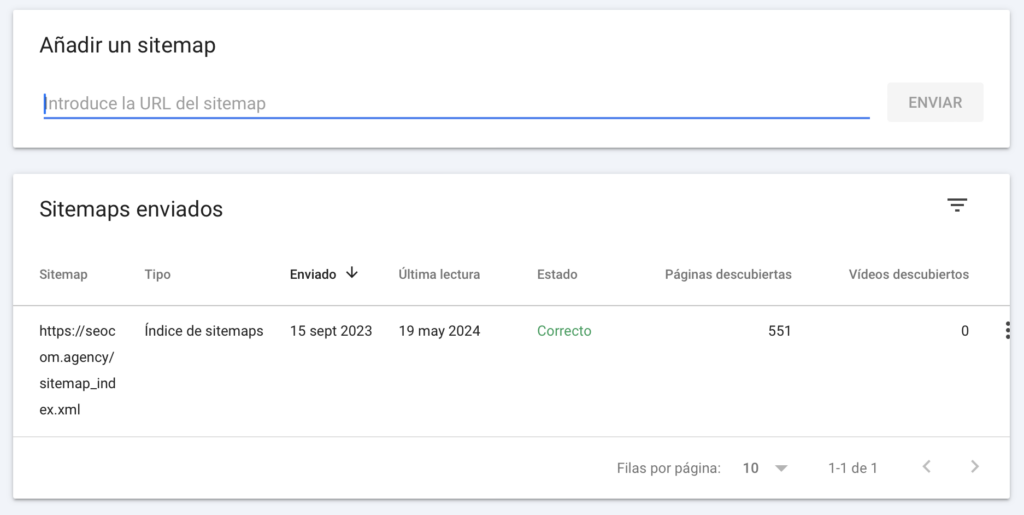

Es importante mencionar que un sitemap puede contener como máximo 50.000 URLs y no debe pesar más de 50mb estando descomprimido. En caso de que estemos trabajando una web masiva, habrá que crear múltiples sitemaps. No hay problema porque un archivo de sitemap puede contener varios sitemaps dentro de este. Para más información sobre como crear y enviar sitemaps, nadie mejor que Google y sus directrices.

Hay varios métodos para asegurarnos que el sitemap es correcto, podemos hacerlo de la manera más manual, que es extraer todas las URLs del sitemap y haciendo una comparación con las URLs importantes de la web.

Nuestra recomendación es hacer uso de Screaming Frog, con la configuración correcta esta herramienta se encarga de analizar todas las URLs, y nos reporta qué URLs están en el sitemap y no deberían estar y por otro lado que URLs deberían estar en el sitemap y no lo están.

Otra parte muy importante es asegurarnos que el sitemap está enviado a Google para que lo tenga en cuenta. Google es capaz de encontrar el sitemap de otras formas, pero enviarlo nos asegurará que lo rastreará prácticamente según lo enviemos, es por eso que es muy recomendable enviar el sitemap a Google.

Otra recomendación que hacemos es utilizar la directiva del robots.txt sitemap: Esta directiva permite enlazar la URL en la que se encuentra el sitemap para que los rastreadores lo encuentren dentro del robots.txt. Un ejemplo sería incluir una línea en el archivo robots.txt que diga:

Sitemap: https://seocom.agency/sitemap_index.xml

Robots.txt

al archivo robots.txt, en éste definimos qué partes de nuestro site queremos que rastree o no. Mediante la orden Disallow, podemos bloquear esas secciones que no queremos que el bot rastree.

Si queremos ver el robots.txt, podemos acceder a él desde cualquier página web en la siguiente dirección de URL: midominio.com/robots.txt

Si quieres aprender más acerca de este archivo, te invitamos a ver el vídeo que hemos creado en nuestro canal de Youtube

Análisis de errores

Como decíamos anteriormente, nos interesa que todas las páginas que queremos posicionar devuelvan un código de estado 200 (OK). Lo cual es esencial para que una página sea indexable y pueda aparecer en los motores de búsqueda.

Hay muchos tipos de código de estado y de errores, pero nosotros nos vamos a centrar en 3.

-

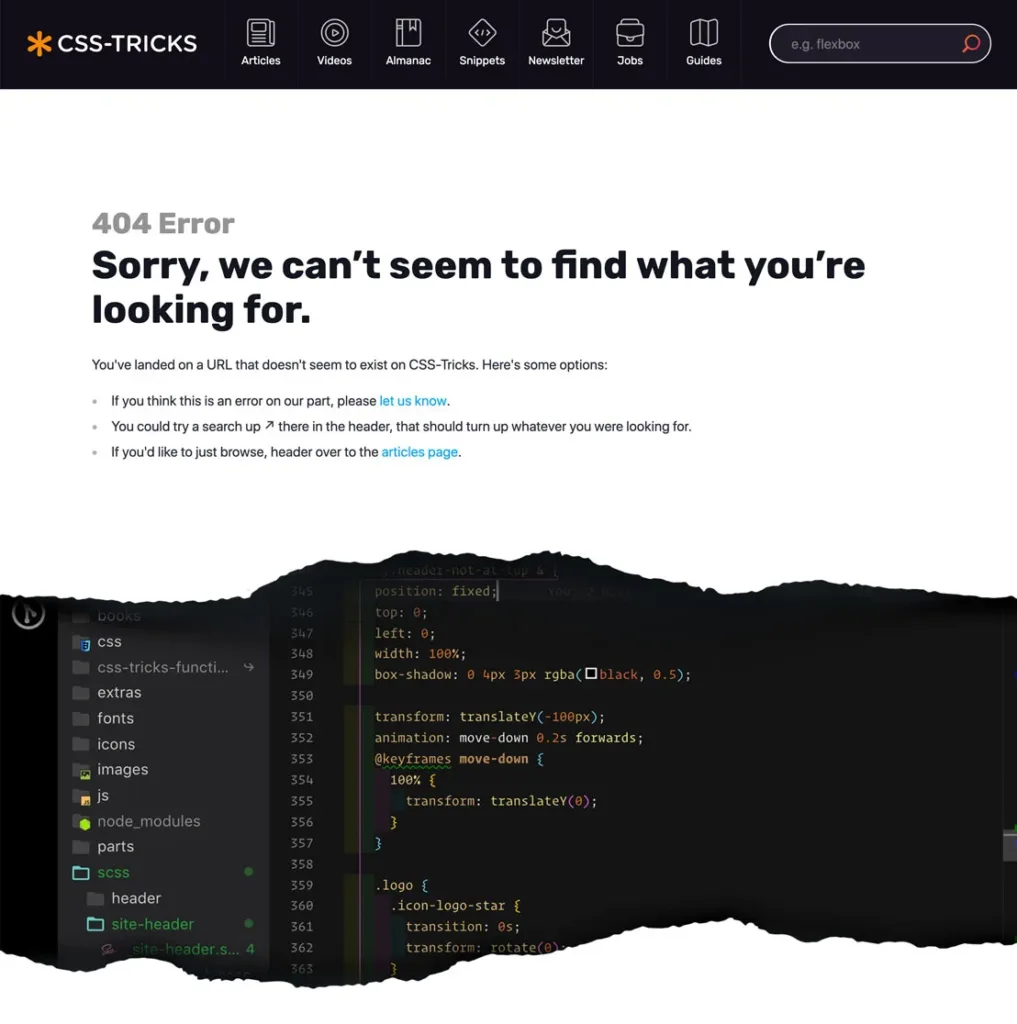

- Error 404: Seguro que ya los conoces, pero un error 404 es una página que no se ha encontrado. Significa que la página no existe, puede ser porque desde alguna parte de la web se enlazaba a una página que en algún momento existió y ya no, o se enlace con algún error en el enlace a una página que no exista. Ya no solo es malo a nivel SEO sino que para un usuario que intenta llegar a una página y se acaba encontrando con la nada tampoco es agradable.

-

- Error 500: Los errores 500 son errores de servidor. Por lo general nosotros desde SEO no podemos saber el motivo por el cual estos tipos de página no están respondiendo, pero hay que tratar de evitar que existan, por lo que habrá que ponerse en contacto con la persona/empresa encargada del servidor para que nos ayude a solucionarlo.

-

- Errores 301 y 302: Aunque no son técnicamente errores, son códigos de estado que indican que hay una redirección, es decir que la URL ha cambiado debido a una directiva del servidor. Por lo general si las redirecciones son lógicas no suelen resultar en problemas graves, y salvo que haya muchas no solemos darle prioridad. Pero aún así hay que mantenerlas vigiladas, ya que una redirección genera una petición extra al servidor y por lo tanto aumenta el tiempo de procesamiento y carga de la página que puede resultar en una experiencia negativa.

Solucionar estos errores, sobre todo los 404 y 500, es importante para evitar tener muchos callejones sin salida en la web.

Contenido

Llegamos a la parte más importante del On Page. Los rastreadores utilizan todo el texto que hay dentro de una página para entender de qué trata y colocarla en el índice de los motores de búsqueda según las palabras clave a las que ellos entienden que responden.

Es por eso por lo que es importante tener detectados ciertos aspectos que son importantes para posicionar dentro del contenido:

-

- Calidad general del contenido: El pilar principal del contenido es que sea de calidad, que realmente sirva de utilidad, que aporte valor, o que responda a las preguntas que puedan tener los usuarios.

-

- Palabras clave: El contenido debe estar optimizado para incluir las palabras clave para las que queremos posicionar. La existencia de estas palabras a lo largo del contenido ayudarán a los rastreadores a entender de qué trata el artículo. Hacer un buen keyword research es clave para poder estructurar un contenido de la mejor forma posible para SEO.

-

- Densidad de palabras clave: En relación con el punto anterior, es importante no pasarnos con la cantidad de palabras que colocamos en el texto, en el sector siempre se habla de ciertos números de densidad de palabras clave de la que no deberíamos excedernos, pero nuestra recomendación es no interpretarlo como algo matemático y simplemente escribir un contenido natural y de calidad evitando sobre optimizar nuestro contenido.

-

- Contenido duplicado: Debemos asegurarnos de que el contenido que publicamos es original, de lo contrario podríamos recibir alguna penalización. Es cierto que para ser penalizados la infracción debe ser muy grave y no va a suceder casi nunca ya que contenido duplicado hay en todos lados. Aun así, hay que intentar evitarlo.

-

- Thin content: Se refiere como thin content a todo contenido pobre o de mala calidad. Simplemente todas las páginas que queramos posicionar deberían tener un contenido mínimo para que no estén completamente vacías y ayuden a los rastreadores a poder entender de qué trata la página.

-

- Canibalizaciones: Es uno de los puntos más complicados del contenido. La canibalización significa que hay varios lugares de la web donde se está intentando posicionar por una misma palabra clave o una misma intención de búsqueda. Aunque muchas veces es imposible evitar la canibalización al 100%, hay que evitar tener varios lugares donde se trabajará la misma palabra clave / intención de búsqueda. Por eso es importante plantear una buena arquitectura como mencionábamos al principio y hacer uso de las etiquetas canonical.

A modo de resumen, en una auditoría nos debemos asegurar que el contenido de las páginas que nos interesa es lo suficientemente extenso, único, de calidad y que incluye las palabras clave para las que nos interesa posicionar.

Además, con todos los cambios de algoritmos que está haciendo Google para proporcionar los mejores resultados a nivel de calidad, es de vital importante trabajar los contenidos teniendo en cuenta factores como el EEAT.

Meta etiquetas

Las meta etiquetas son un tipo de etiquetas que utiliza Google para poder representar información de nuestra web en sus resultados de búsqueda.

Principalmente se dividen en 2 tipos. Las meta-title, que son los títulos en azul que vemos de cada una de las páginas cuando realizamos una búsqueda, y las meta-description, que son las descripciones que aparecen justo debajo de los títulos. Cada una de estas etiquetas deben ser optimizadas principalmente para aumentar nuestro CTR, ya que cuanto más llamativas sean, más posibilidades tenemos de captar el interés del usuario. Nuestras recomendaciones para cada una de ellas son:

Para los títulos:

-

- Debe ser único y no repetirse en otras páginas

-

- Se debe incluir una palabra clave, y dentro de lo posible al principio del mismo

-

- El tamaño no debe superar los 65 caracteres o los 600 píxeles de ancho si nos ponemos más técnicos.

Para las meta descripciones

-

- Tampoco deberían repetirse en más de 1 página

-

- Se debería incluir la palabra clave, en este caso no es tan relevante la ubicación de la palabra clave.

-

- Debe incluir una llamada a la acción para atraer la atención del usuario y poder así aumentar el CTR.

-

- El tamaño de la descripción no debe superar los 155 caracteres o los 928 píxeles.

En una auditoría nos aseguramos que tanto los meta titles y meta descriptions, al menos de las páginas más importantes del proyecto, cumplen con las directrices que mencionamos.

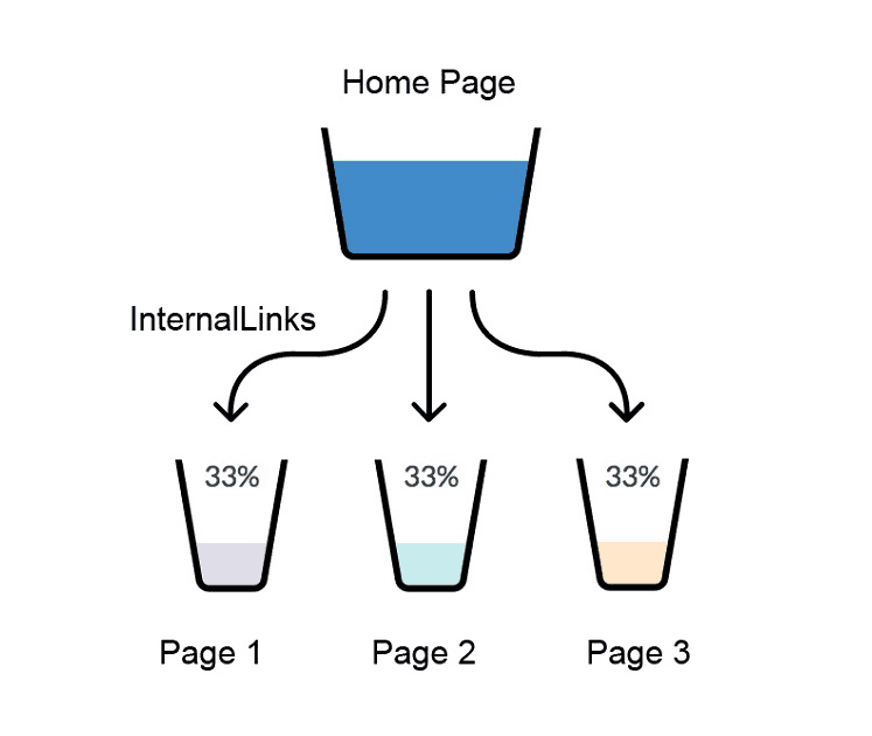

Enlazado interno

El enlazado interno es una de las partes más importantes de cualquier web. Un buen enlazado interno ayuda muchísimo al posicionamiento de la web tanto porque al enlazar a otras páginas las dotamos de más fuerza, así como también podemos mejorar las posiciones de las palabras clave si utilizamos los anchor text de forma correcta.

Cuando auditamos el enlazado interno de una web, me suelo fijar que las páginas más importantes sean las que más enlaces internos reciben, pero mucho más que eso, me aseguro de que estas páginas están recibiendo enlaces con los anchor text con las palabras clave que quiero posicionar.

Para este análisis una vez más utilizamos Screaming Frog, que nos permite ver cuantos enlaces internos está recibiendo una URL, y también saber desde que URLs está recibiendo los enlaces y con qué anchor text.

De cara a la estrategia es interesante tener detectadas que páginas son las más fuertes del proyecto y utilizarlas para enlazar hacia las páginas que más nos interesan, utilizando como anchor text la palabra clave que más nos interesa.

Velocidad de carga

La velocidad de carga es un aspecto importante para el posicionamiento. O debería serlo. Esto lo digo porque Google nos lleva amenazando que la velocidad de carga va a ser un factor de posicionamiento importante desde hace ya mucho tiempo, pero realmente no ha sido para tanto (Como siempre).

Aún así, aunque parezca que le esté quitando importancia al asunto, no es así, una buena velocidad de carga es importante ya no solo para Google y sus rastreos, sino para el usuario. Creo que todos en algún momento de nuestras vidas hemos intentado acceder a una página para resolver una duda o mirar algún producto y salir rebotados porque hemos perdido la paciencia esperando a que la web cargue.

Es por eso que, aunque muchas veces mejorar la velocidad de carga no influye directamente en el posicionamiento la solemos trabajar. Para ello hacemos uso de varias herramientas que vamos a listar:

https://gtmetrix.com/ : Es una herramienta que proporciona un informe super detallado de diferentes campos relacionados con la velocidad de la web que se pueden utilizar para mejorar la velocidad de carga de esta.

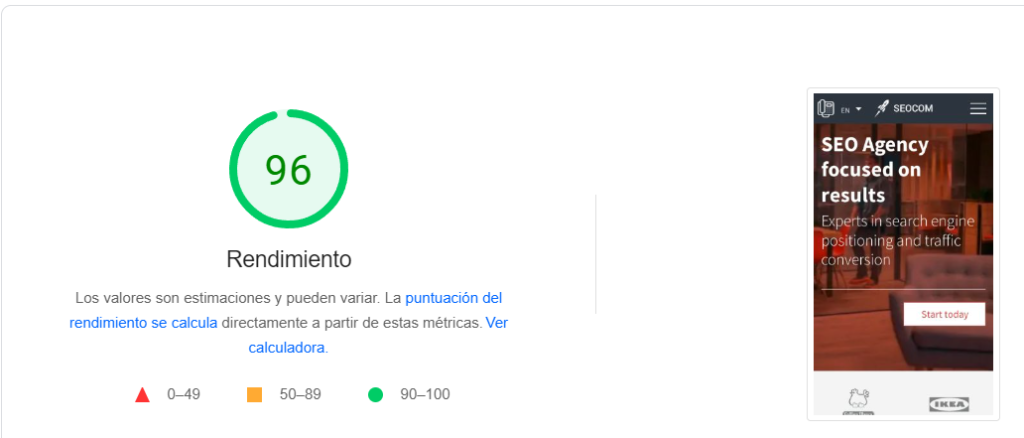

https://pagespeed.web.dev/ : Es una herramienta de la propia Google, esta reporta unos datos más simples pero útiles ya que es la propia Google la que nos está haciendo el test. Lo bueno es que aporta una nota de 0 a 100 con la que puntúa la velocidad general de la web y es una forma sencilla de saber el estado de nuestra velocidad de carga. De todas formas, el dato más importante que nos aporta pagespeed insights es la evaluación de las métricas web principales, o más conocidas por el término en inglés (Core Web Vitals o las siglas CWV). Estas métricas son las que mencionábamos al principio, que superarlas con éxito sería positivo para el posicionamiento.

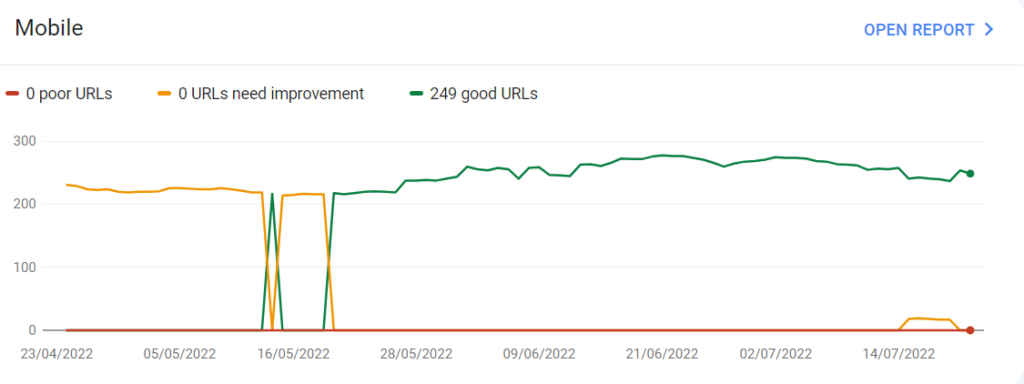

https://search.google.com/search-console/ : Ya hemos hablado varias veces de Google Search Console, esta herramienta también tiene un informe sobre el estado de los core web vitals de la web. Mientras que el informe de pagespeed insights es útil para conocer qué hay que hacer para mejorar los CWV, el informe de Google Search Console es útil para hacer un seguimiento del estado de estas métricas. En la sección de Core Web Vitals de search console, podremos ver un informe con datos reales de la experiencia de usuarios que han accedido a nuestra web en los últimos 90 días.

Imágenes

Cuando hablamos de las imágenes probablemente podamos encontrar opiniones muy variadas en el sector. Personalmente hablando, hace bastante tiempo que dejé de dar mucha prioridad a las imágenes salvo que realmente fuesen a aportar algún valor (Ej. Webs de recetas, ecommerce donde el apartado visual es importante o proyectos en el que hay búsquedas relacionadas con imágenes) Y aún así, en la mayoría de estos proyectos siempre había otras prioridades más importantes que las imágenes.

Hay gente que trabaja la optimización del atributo ALT, que es un tipo de atributo que ayuda a entender sobre que trata la imagen. Yo generalmente indico a mis clientes que en la medida de lo posible lo hagan cuando suban imágenes, pero cuando entra un proyecto no me suelo poner a hacerlo ya que no suele merecer la pena. Pero lo dicho anteriormente, si el proyecto lo necesita por sus necesidades obviamente sí, pero no suele ser el caso.

De todas formas las reglas del juego están volviendo a cambiar, y ahora estoy volviendo a dar mucha importancia a las imágenes. Últimamente Google ha estado trasteando con un módulo de carrusel de imágenes en la SERP, hablamos de un módulo super llamativo que definitivamente quieres tener.

Para más información de como conseguir este módulo en https://brodieclark.com/google-image-thumbnails/ . (En inglés)

Uso de Schema

Otro factor que solemos analizar es el uso de Schema. Esto es un tipo de etiquetado que aunque a nivel visual no aporta nada. Ayuda a los motores de búsqueda a entender la estructura de la página, y ellos a cambio “nos recompensan” colocando módulos que hacen que nuestros resultados de búsqueda se vean más visuales y llamativos, y por lo tanto mejore nuestro CTR.

Por lo general nos centramos en los schemas más lógicos y que más visibilidad nos aportan en la SERP. Que suelen ser:

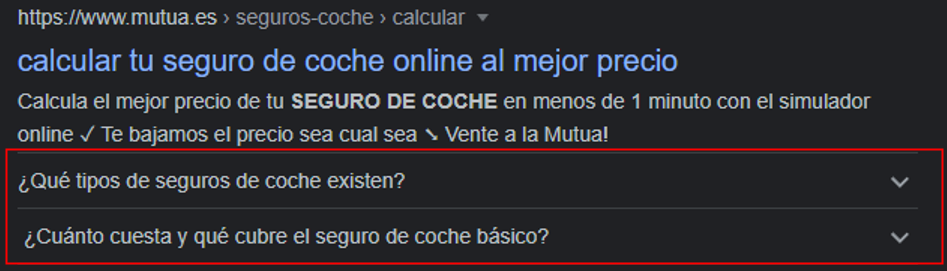

-

- FAQ: Frequently Asked Questions, si en algún lugar de la página tenemos una sección de preguntas y respuestas, nos conviene etiquetarlo con marcado schema, ya que podrá hacer que el módulo de estas preguntas aparezca en Google, haciendo que nuestro resultado ocupe un poco más de espacio y sea más llamativo.

-

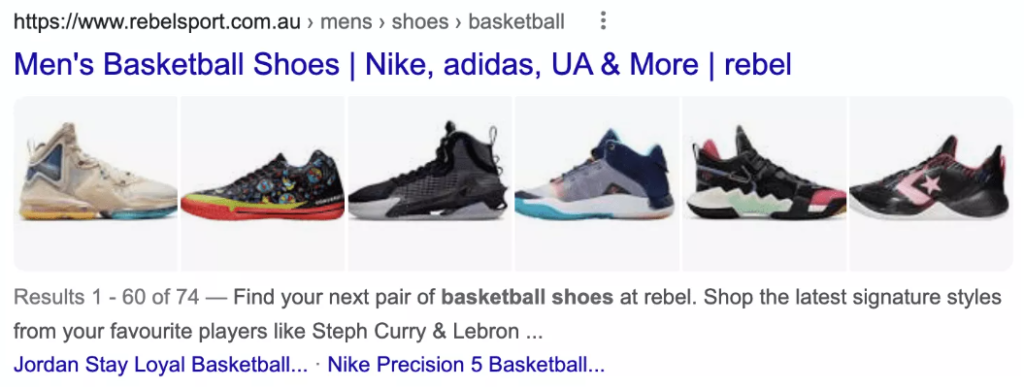

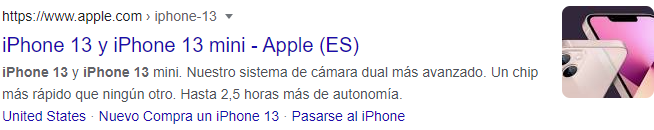

- Product: Se utiliza para las fichas de producto, aunque no siempre es necesario para que aparezcan los módulos, se recomienda hacerlo para que la imagen del producto pueda aparecer en nuestro resultado de búsqueda.

-

- Breadcrumb: Si nuestra web tiene migas de pan para la navegación, recomendamos implementar el schema breadcrumb, esto hará que la navegación aparezca en el resultado de búsqueda.

-

- Article: Si escribimos un artículo conviene marcarlo como article para que Google nos pueda poner en sus módulos de artículos relevantes cuando un usuario hace una búsqueda en la que nuestro artículo pueda ser relevante.

-

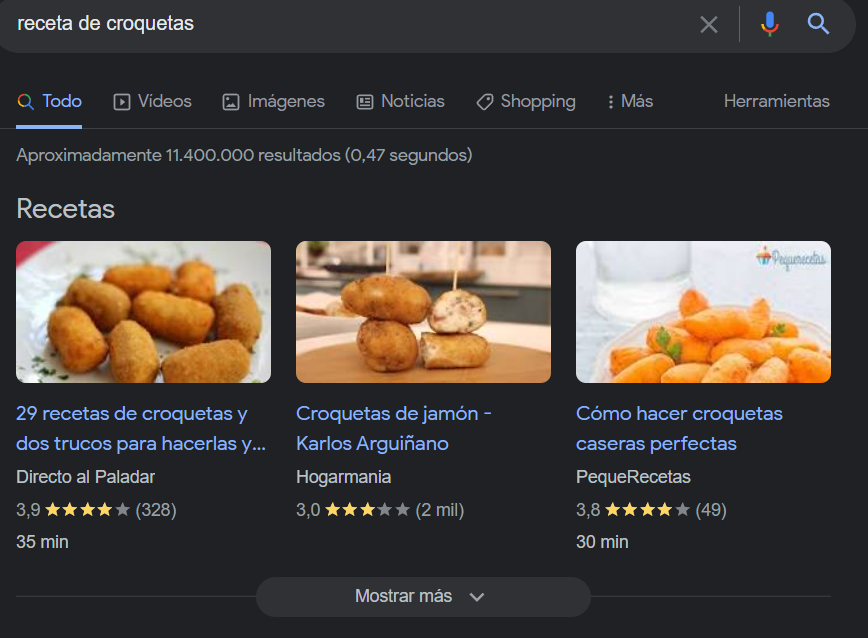

- Recipe: Si tenemos una web con recetas el schema de récipe es muy importante ya que le da un estilo muy llamativo al resultado de búsqueda, no tenerlo es prácticamente un pecado.

Cada uno aporta un tipo de información diferente y hace que aparezcan distintos módulos en Google. Conocerlos y saber cuándo implementarlos es importante.

Hreflang

Si nuestra web es multi-idioma, habrá que analizar el estado de los Hreflang.

La etiqueta hreflang es una etiqueta que se encarga de indicar a los rastreadores cuales son las URLs equivalentes en distintos idiomas. Esto es especialmente útil para que los motores de búsqueda conozcan cuando un contenido no se está simplemente duplicando y hacia qué idioma está orientado. También para poder transmitir la fuerza de una página hacia sus hermanas en otros idiomas.

Para esto, de nuevo hacemos uso de Screaming Frog. En ella podemos si las URLs tienen etiquetas hreflang, y en caso de que lo hagan, hacia que otras URLs enlazan.

Sobre lo que hay que analizar no tiene mucho misterio, simplemente nos debemos asegurar que si una URL tiene una versión alternativa en otro idioma debe estar enlazada por una etiqueta hreflang.

También hay que asegurarse que las URLs con hreflang cumplen con una serie de directrices:

-

- Toda URL que vaya a tener un hreflang para otro idioma, también debe tener una para ella misma.

-

- Si una URL enlaza hacia otra con un hreflang, la del destino tiene que enlazarla de vuelta, si no será como si no tuvieran nada.

-

- Todas las URLs que tienen hreflang deben ser indexables

-

- Los enlaces deben ser absolutos.

-

- Las URLs pueden estar en dominios diferentes, pero sigue siendo importante que se enlacen entre sí.

Canonicals

Debemos asegurarnos de que todas las páginas que queremos posicionar son canónicas para su correcta indexación. En ocasiones puede pasar que en algún proyecto por error una de las URLs importantes tiene una etiqueta canonical hacia otra URL, y por culpa de eso esa URL no indexa correctamente. Es un punto muy simple pero importante de analizar.

SEO Off-Page

Una vez terminados con el On Page, le toca al Off Page. Toda la parte externa a la web, generalmente relacionado con todo lo que es Autoridad y enlaces externos.

Perfil de enlaces

El pilar principal del Off Page es el perfil de enlaces. Es importante analizar el perfil de enlaces de una web ya que con esto podremos conocer más o menos el alcance que tenemos y con quién podemos pelearnos en la SERP y con quién no (Aunque siempre se puede pelear si las cosas se hacen bien)

El perfil de enlaces se compone de los enlaces que recibe la web desde otras webs de internet. Estos enlaces son muy importantes ya que los motores de búsqueda interpretan que si una web externa nos está enlazando es porque somos relevantes. Cuanto más relevante sea la web que nos está enlazando, mejores resultados obtendremos es por eso que conocer nuestro perfil de enlaces es importante.

Hay varios factores a analizar dentro del perfil de enlaces:

-

- Cantidad de dominios que enlazan a nuestra web, es más importante recibir enlaces de una mayor cantidad de dominios que una mayor cantidad de enlaces en pocos dominios

-

- Calidad / Autoridad de los dominios que nos están enlazando

-

- Temática: La temática de los dominios que no están enlazando. Cuanto más afín sea la temática, mejor.

-

- Naturalidad: Es importante que se nos enlace de manera natural y no de forma spammeada. El SPAM puede resultar en una penalización, y una penalización de este tipo puede ser muy dura.

Para trabajar el perfil de enlaces se suelen utilizar dos técnicas

-

- Linkbuilding: La más sencilla y utilizada. Se trata conseguir enlaces de otras webs mediante acuerdos, bien sea comprando un artículo con un enlace, un intercambio, guest posting o todo lo que sea básicamente consiguiendo un enlace a cambio de algo.

-

- Linkbaiting: Es la forma más natural e ideal de conseguir enlaces, pero se trata de crear contenidos de calidad que hagan que demás webs de internet nos enlacen. Por lo general con el linkbuilding se consiguen enlaces de páginas con más autoridad y que tienen un mayor impacto en SEO, pero una buena estrategia de linkbaiting es la forma más ética y natural de mejorar nuestro perfil de enlaces.

Otras ramas más allá del SEO puro

Y aunque el SEO Puro sea lo que hemos mencionado en todo lo anterior, también hay muchos otros palos que podemos tocar con el fin de hacer que nuestro proyecto funcione lo mejor posible.

Es importante conocer nuestras opciones dentro de este mundo que es el marketing digital. Y poder hacer recomendaciones cuando sabemos que hacer uso de estas técnicas beneficiará al proyecto.

Uno de los pilares muy importantes en cualquier web es todo lo relacionado con el diseño, CRO… Hacer uso de técnicas como el A/B Testing y ver que diseños y que layouts de la web funcionan mejor son muy útiles para poder generar una mayor cantidad de ingresos en nuestro proyecto.

Otras ramas interesantes de las que nos podemos beneficiar son especialidades como el email marketing, el marketing en redes sociales, o el uso de SEM.

Después tener la mente abierta y conocer el sector nos ayudará a pensar que tal vez un sistema de afiliación puede ser útil para un cliente, en el que si ofrece unas comisiones competentes, tendrá todo tipo de gente del mundo del marketing digital consiguiéndonos ventas…

Conclusiones

Creo que a lo largo de este post ya hemos dejado claro lo importante que significa llevar a cabo una auditoría SEO. Si queremos que nuestro proyecto logre una cierta visibilidad y tenga un espacio en Google, tendremos que trabajar mucho para conseguirlo.

La auditoría es uno de muchos pasos que necesitas hacer para conseguir una buena estrategia SEO, pues como sabrás, Google cada vez va cambiando sus algoritmos y lo que puede servirte hoy, mañana a lo mejor ya no funciona.

En nuestra agencia de marketing digital nos mantenemos siempre al tanto de las últimas tendencias y novedades del sector. No se nos pasa una (Emoji guiño).

Si quieres contratar una auditoría SEO, desde SEOCOM estaremos encantados de hablar contigo y encontrar la mejor forma de ayudarte.

Para cualquier otra duda que no hayas entendido, nos encantaría que dejaras tu comentario para poder ayudarte. También nos gustaría que aportaras tu punto de vista sobre algún tema en concreto en caso de que nos hayamos dejado cualquier detalle.